ollama的常用操作

在交互模式下,输入 /bye 或按下 Ctrl+D 退出。默认情况下,服务器会监听 localhost:11434。然后后续就可以使用ollama相关的库包来调用该url。运行后,会进入交互式对话模式,可以直接与模型对话。

·

一、下载和删除模型

ollama pull <model_name>

# 支持下载多种模型

ollama pull llama2

ollama pull mistral

ollama pull gemma

ollama rm <model_name>

二、运行模型

ollama run <model_name>

运行后,会进入交互式对话模式,可以直接与模型对话。

在交互模式下,输入 /bye 或按下 Ctrl+D 退出。

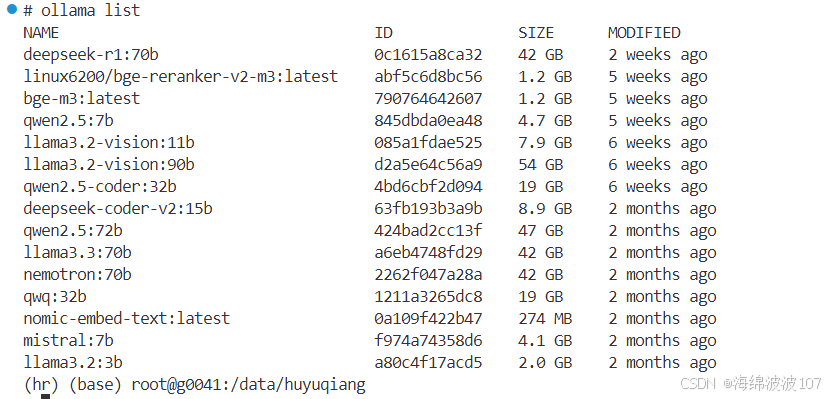

三、查看已下载的模型

ollama list

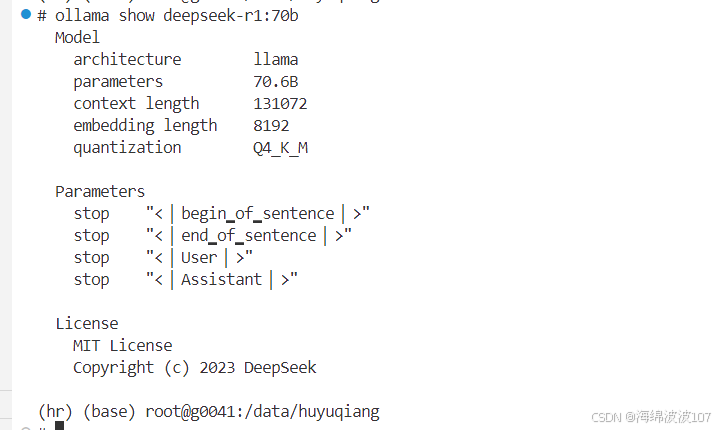

四、查看模型信息

ollama show <model_name>

五、运行模型服务器

Ollama 可以作为一个本地服务器运行,允许通过 API 调用模型:

ollama serve

默认情况下,服务器会监听 localhost:11434。

然后后续就可以使用ollama相关的库包来调用该url

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)