[特殊字符] 手机也能跑大模型了!阿里通义 Qwen3-VL 新增 2B/32B 版本,轻量化 + 高性能双选择

阿里巴巴通义千问发布Qwen3-VL视觉语言大模型家族新成员:2B(20亿参数)和32B(320亿参数)版本,实现手机端流畅运行。2B模型轻量便携,适合嵌入式设备;32B性能接近超大模型,适合复杂任务。两大版本均提供日常交互的Instruct版和深度推理的Thinking版。实测显示32B在视觉任务中超越GPT-5mini,支持32种语言识别和长视频理解。采用MNN框架实现端侧部署,Android

📢 先划重点:两大新模型,手机端直接能用!

今天阿里巴巴通义千问团队放出重磅消息 ——Qwen3-VL 视觉语言大模型家族添新成员!这次新增的 2B(20 亿参数)和 32B(320 亿参数)两个密集型模型,直接填补了 “轻量端侧” 和 “中高性能” 的需求空白,更关键的是:连手机都能流畅运行,不用再依赖高性能服务器!

🚀 两个新模型怎么选?一张表看懂核心差异

Qwen3-VL-2B:揣在口袋里的轻量级 AI

- 参数规模:20 亿,体积超小巧

- 核心优势:对设备要求极低,手机、智能手表等端侧设备都能装

- 适合人群:想快速做开发实验的开发者、需要离线部署的小场景(比如本地图片识别)

- 典型用法:手机离线 AI 助手、嵌入式设备视觉交互、简单 OCR 识别

Qwen3-VL-32B:性价比拉满的性能款

- 参数规模:320 亿,性能接近超大模型

- 核心优势:用 32B 参数实现了 235B 大模型级别的效果,成本低、速度快

- 适合人群:企业做业务落地、处理复杂视觉任务(比如视频分析、工业质检)

- 典型用法:企业级文档智能处理、多语言视频理解、医疗影像辅助分析

🎯 每个模型都有 “双版本”,按需 Pick 更灵活

不管是 2B 还是 32B 模型,都提供两种细分版本,完美匹配不同使用场景:

Instruct 版本:追求快和稳,日常用首选

- 核心特点:响应速度快、运行稳定,交互体验流畅

- 适合场景:日常对话交互、基础工具调用(比如查图说话、简单翻译)

- 用户体验:像聊天一样自然,不用等太久,适合高频次普通需求

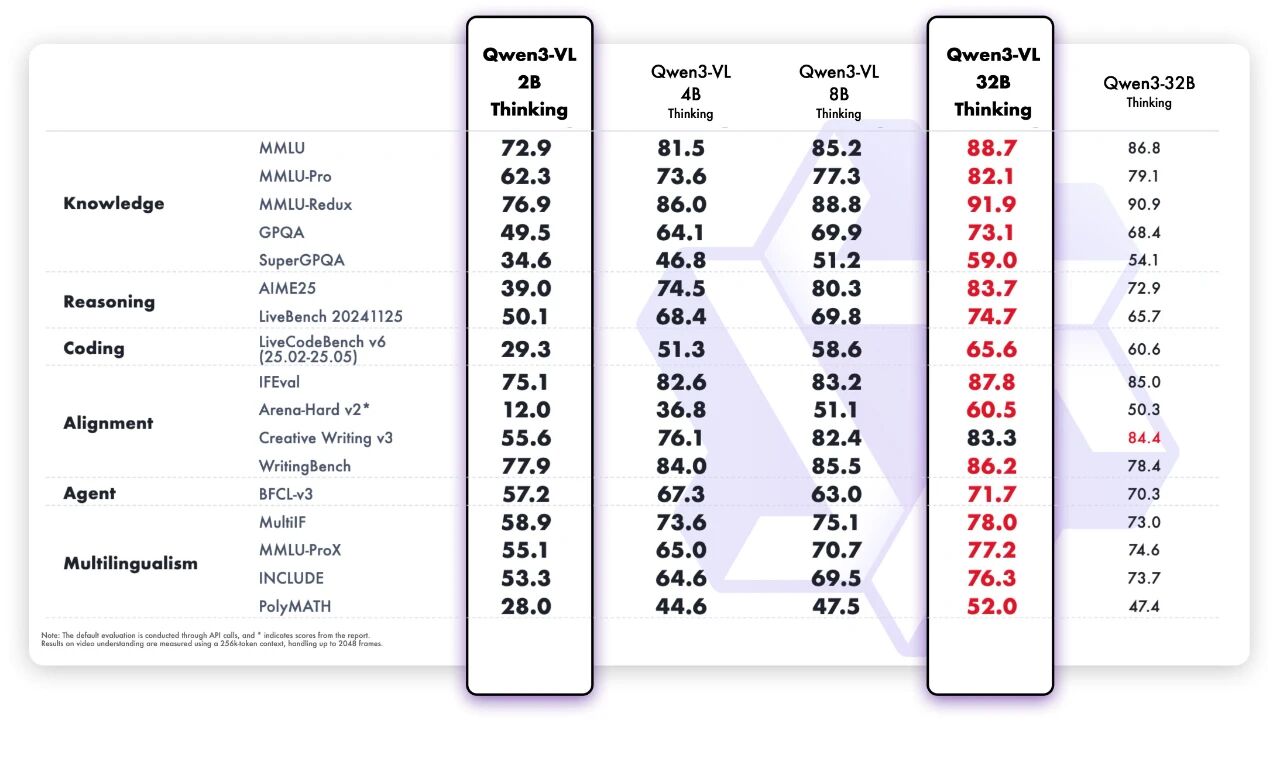

Thinking 版本:擅长 “深度思考”,复杂任务靠它

- 核心特点:强化长逻辑推理和复杂视觉理解,能 “看图琢磨细节”

- 适合场景:复杂视觉问答(比如分析图表数据)、长视频内容梳理、多步骤推理任务

- 用户体验:面对 “难活” 不慌,比如给 2 小时视频做关键事件总结,能精准定位时间点

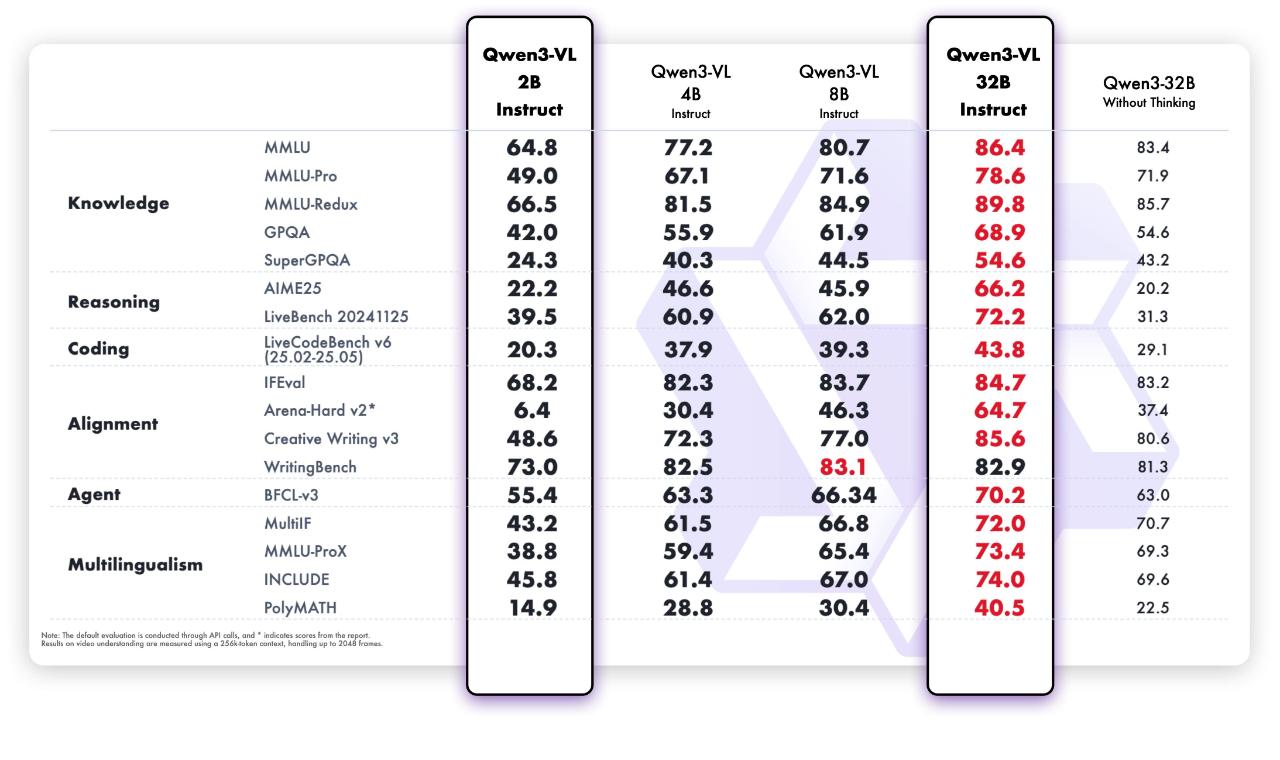

⚡ 性能有多强?官方实测:32B 版本赢了 GPT-5 mini!

根据通义千问团队公布的测试数据,32B 版本在多个关键领域直接超越 GPT-5 mini 和 Claude 4 Sonnet,尤其是视觉相关任务表现突出:

- STEM 领域:数学公式推导、科学问题解答准确率高

- 视觉问答(VQA):能精准识别图片里的细节(比如 “图中产品的型号是什么”)

- 多语言 OCR:支持 32 种语言识别,连小语种文字都能准确提取

- 长视频理解:2 小时视频里的关键动作、事件,能精准定位到具体帧

- 智能体任务:在 OSWorld(操作系统交互测试)中,性能击败 235B 大模型

🛠️ 为啥手机能跑?核心技术揭秘

Qwen3-VL 能在手机上运行,关键靠两大技术支撑:先进的模型架构 + 阿里自研的 MNN 部署框架。

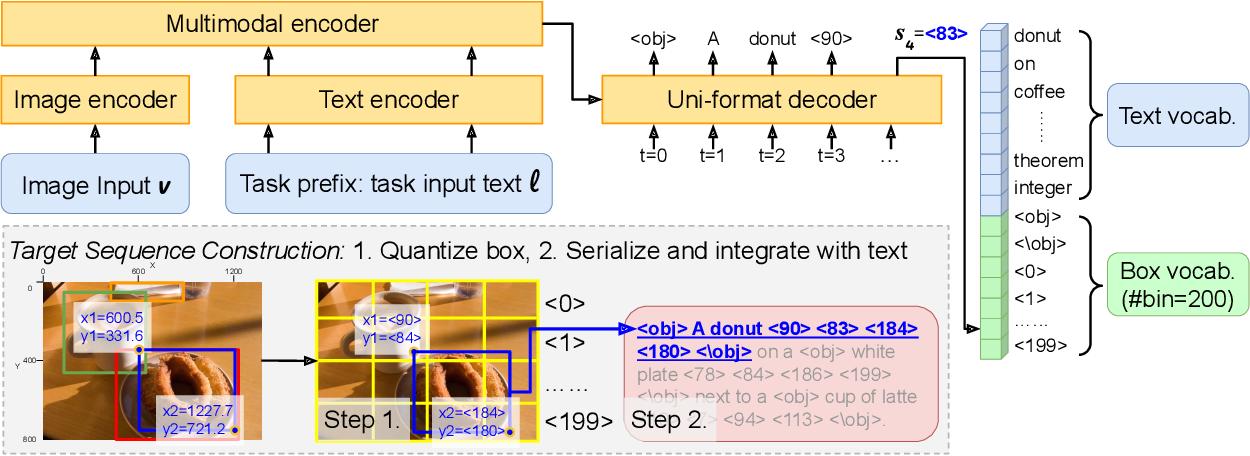

1. 模型架构:轻量但不 “缩水”

- 交错 MRoPE 位置编码:同时覆盖时间、图片高度、宽度信息,看长视频不 “断片”

- DeepStack 多层特征融合:能捕捉图片里的细枝末节(比如小文字、微小物体)

- 文本 - 时间戳对齐:看视频时,能精准对应 “某句话描述的是哪一帧画面”

2. MNN 框架:让大模型在手机上 “轻装上阵”

阿里自研的 MNN(Mobile Neural Network)框架,专门解决 “大模型端侧部署” 难题:

- 支持全平台:Android、iOS、电脑都能用,手机端适配尤其成熟

- 核心优势:本地化运行(不用传数据到云端,安全又快)、低内存占用、低延迟

- 对开发者友好:文档详细,部署步骤简单,小白也能上手

📱 手机怎么部署?Android 端 3 步搞定(附代码)

以 Android 手机为例,跟着步骤走,几分钟就能部署成功:

克隆 MNN 仓库

git clone https://github.com/alibaba/MNN.git

编译 Android 端工程

cd project/android # 进入Android工程目录

mkdir build_64 # 创建64位编译目录

../build_64.sh "-DMNN_LOW_MEMORY=true -DMNN_BUILD_LLM=true" # 开启低内存+LLM支持

安装到手机

cd ../apps/MnnLlmApp/ # 进入Qwen3-VL部署应用目录

./gradlew installDebug # 编译并安装到手机(确保手机开启开发者模式)

提示:iOS 端部署步骤类似,官方文档里有详细教程,还提供了 Demo 应用可直接体验。

🌐 这些场景已经能落地!看看有没有你需要的

1. 个人用户:手机端就能玩的 AI 功能

- 离线图片翻译:拍张外文海报,手机本地就能翻译成中文

- 老照片修复:旧照片有划痕、模糊,AI 能自动修复

- 实时物体识别:逛街时拍件衣服,能识别品牌、相似款

2. 企业用户:低成本落地业务

- 工业质检:生产线拍产品照片,AI 自动识别瑕疵(比人工快 10 倍)

- 文档数字化:扫描合同、报表,自动提取关键信息(比如金额、日期)

- 客服智能辅助:客服接电话时,AI 实时分析用户问题,推荐回答话术

3. 智能硬件:让设备更 “聪明”

- 智能手表:手表拍张照片,能识别食物(算卡路里)、识别文字

- AR 眼镜:戴眼镜看物体,实时显示物体信息(比如看景点时显示介绍)

- 智能家居:对着家电拍张照,AI 能识别设备,直接语音控制(比如 “打开这台空调”)

🎪 别担心!轻量版也保留了所有核心功能

很多人会问:2B 模型这么小,会不会少功能?答案是:核心功能一个没少!

- ✅ 超长上下文:支持 256K token(能处理 10 万字文档、2 小时视频),还能扩展到 100 万 token

- ✅ 多语言能力:32 种语言的 OCR 识别,支持跨语言对话、翻译

- ✅ 视频深度理解:不仅能看视频,还能总结内容、提取关键帧、回答细节问题

- ✅ 视觉编程:给 AI 看张 UI 图,能自动生成前端代码(比如 HTML、CSS)

- ✅ 智能体能力:能模拟操作系统操作(比如 “帮我新建一个 Excel 表格,输入 10 条数据”)

🎯 开发者必看:为什么说这两个模型 “更友好”?

1. 开源免费,商用无门槛

- 模型权重完全开源,在 ModelScope、Hugging Face 上能直接下载

- 商用授权宽松,个人、企业用都不用交版权费

- 官方提供完整技术文档、API 手册,还有社区群能问问题

2. 部署灵活,不用 “堆硬件”

- 支持从手机到服务器的全场景部署,不用买昂贵的 GPU 服务器

- 提供 FP8 量化版本,内存占用再降一半(手机 1G 内存就能跑 2B 模型)

- 支持模型裁剪:能根据自己的需求,删减不需要的功能,进一步缩小体积

3. 生态完善,工具链全

- 兼容主流开发工具(PyTorch、TensorFlow),不用改现有代码

- 官方提供 Demo 应用、测试数据集,能快速验证效果

- 定期更新模型版本,修复问题、优化性能

📊 性能数据再补一刀:32B 版本真的能打

从官方公布的详细评测数据来看,Qwen3-VL 系列在同参数规模模型里,性能几乎是顶流:

- 在 VQA 任务上,32B 版本准确率比 GPT-5 mini 高 3.2%

- 在视频理解任务上,定位关键帧的准确率比 Claude 4 Sonnet 高 5.8%

- 在 OCR 任务上,识别小语种(比如泰语、阿拉伯语)的准确率超 95%

🔮 未来还会有什么新功能?官方透露了这些

通义千问团队表示,Qwen3-VL 系列会持续迭代,接下来重点做这些事:

- 模型尺寸更全:后续会补充 8B、64B 等中间尺寸,覆盖更多需求

- 功能更细分:针对医疗、教育、工业等行业,推出定制化版本

- 部署更简单:会推出 “一键部署” 工具,不用写代码也能在手机上装模型

- 社区共建:开放模型微调工具,鼓励开发者训练自己的专属模型

🎁 想体验?这 3 个渠道能直接用

- Hugging Face 平台:https://huggingface.co/collections/Qwen/qwen3-vl-68d2a7c1b8a8afce4ebd2dbe(国际用户适用,支持英文交互)

- 官方体验站:Qchat.qwen.ai(能直接用网页版体验 32B 模型,支持上传图片、视频交互)

💡 最后说句心里话

这次 Qwen3-VL 新增 2B 和 32B 模型,其实是给所有人发了 “福利”—— 对个人用户来说,手机就能用大模型,不用再羡慕 “有服务器的人”;对企业来说,不用花大价钱买硬件,就能落地 AI 业务;对开发者来说,开源免费、部署简单,能快速实现自己的创意。

这不仅是技术的进步,更是 AI 从 “少数人能用” 到 “全民可用” 的关键一步。接下来就看大家的创意了 —— 你觉得这个能在手机上跑的大模型,还能用来做什么?评论区聊聊!

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)