实时目标检测新标杆!DEIMv2 携8大模型横扫 COCO,50M 参数狂揽 57.8 AP,覆盖全设备场景

实时目标检测新标杆!DEIMv2 携8大模型横扫 COCO,50M 参数狂揽 57.8 AP,覆盖全设备场景

《博主简介》

小伙伴们好,我是阿旭。

专注于计算机视觉领域,包括目标检测、图像分类、图像分割和目标跟踪等项目开发,提供模型对比实验、答疑辅导等。

《------往期经典推荐------》

二、机器学习实战专栏【链接】,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

目录

1. 引言

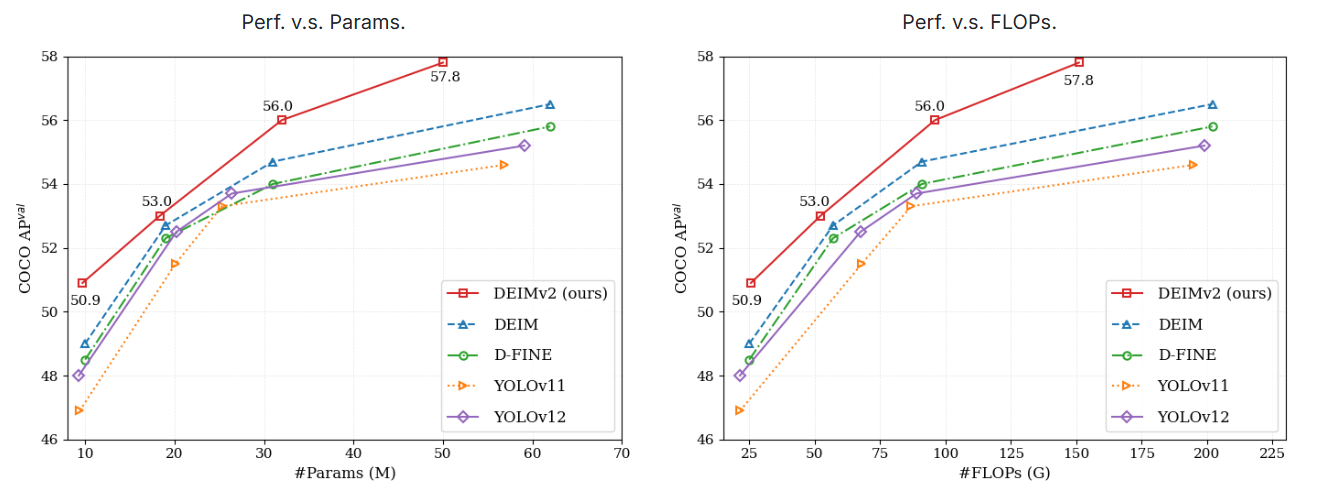

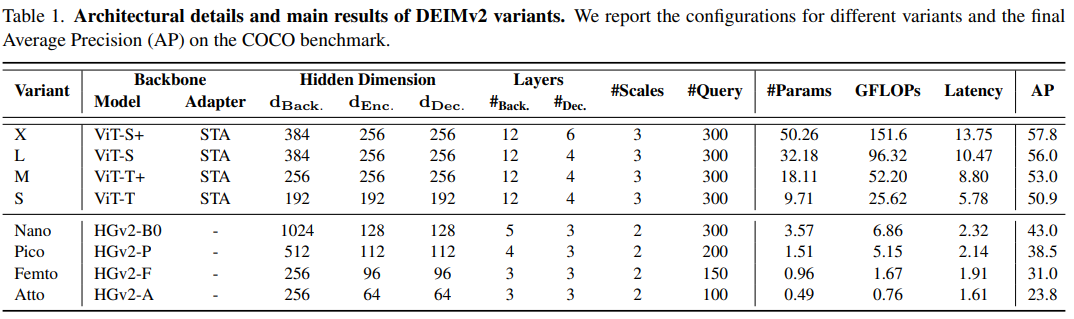

DEIMv2是基于DEIM框架结合DINOv3特征提出的实时目标检测器,涵盖从X到Atto的8种模型尺寸以适配GPU、边缘及移动设备部署;其中X/L/M/S变体采用DINOv3预训练/蒸馏骨干网络并引入空间调优适配器(STA) 实现单尺度到多尺度特征转换,超轻量变体(Nano/Pico/Femto/Atto)则通过剪枝HGNetv2满足资源约束,同时搭配简化解码器与增强型Dense O2O;在COCO数据集上,DEIMv2性能卓越,如DEIMv2-X以50.26M参数达57.8 AP,DEIMv2-S以9.71M参数成为首个突破50 AP的亚10M模型,DEIMv2-Pico仅1.51M参数却达38.5 AP(较YOLOv10-Nano参数减少约50%),整体超越现有主流实时检测器,树立新性能标杆。

论文地址:https://arxiv.org/pdf/2509.20787

源码地址:https://github.com/Intellindust-AI-Lab/DEIMv2

2. 研究背景与目标

- 领域挑战:实时目标检测需在性能(检测精度)与效率(参数、计算成本)间平衡,尤其轻量模型需适配边缘/移动设备。

- 现有基础:DEIM是实时DETR主流训练框架,DINOv3具备强特征表示能力,但二者在实时检测中的潜力未充分挖掘。

- 研究目标:结合DEIM与DINOv3,提出DEIMv2,覆盖全尺度部署场景,突破性能-效率边界。

3. DEIMv2整体架构与核心设计

3.1 架构框架

遵循RT-DETR设计,包含骨干网络→混合编码器→解码器三部分:

- 编码器:处理骨干网络多尺度特征,生成初始检测结果并筛选Top-K候选框;

- 解码器:迭代优化候选框,输出最终预测。

3.2 骨干网络设计(按模型规模分类)

| 模型类别 | 变体 | 骨干网络 | 关键调整 |

|---|---|---|---|

| 中大型 | X | ViT-S+(DINOv3预训练) | 12层,隐藏层维度384 |

| 中大型 | L | ViT-S(DINOv3预训练) | 12层,隐藏层维度384 |

| 中大型 | M | ViT-T+(DINOv3蒸馏) | 12层,隐藏层维度256 |

| 中大型 | S | ViT-T(DINOv3蒸馏) | 12层,隐藏层维度192 |

| 超轻量 | Nano | HGNetv2-B0 | 5层,输出1/16尺度 |

| 超轻量 | Pico | HGNetv2-P(剪枝B0) | 4层,移除B0第4阶段,输出1/16尺度 |

| 超轻量 | Femto | HGNetv2-F(剪枝Pico) | 3层,Pico最后阶段块数从2→1 |

| 超轻量 | Atto | HGNetv2-A(剪枝Femto) | 3层,Femto最后阶段通道从512→256 |

3.3 关键创新模块

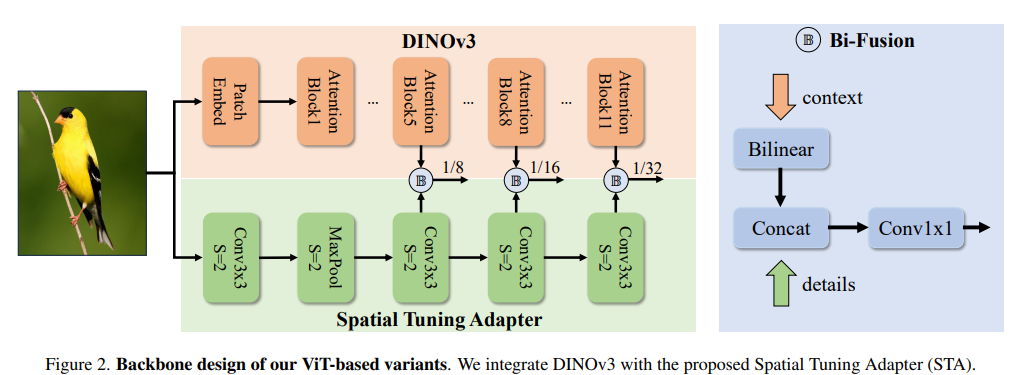

- 空间调优适配器(STA):

- 功能:并行于DINOv3,无参数双线性插值将ViT多块(如5/8/11块)1/16尺度特征转为多尺度,搭配轻量CNN提取细粒度细节,补充DINOv3语义特征;

- 优势:兼顾效率与精度,适配实时检测多尺度需求。

- 高效解码器:

- 优化1:用SwiGLUFFN替代传统FFN,增强非线性表示;

- 优化2:用RMSNorm替代LayerNorm,稳定训练并加速;

- 优化3:共享所有解码器层的查询位置嵌入,减少冗余计算(因查询位置迭代变化小)。

- 增强型Dense O2O:

- 基础:DEIM的Dense O2O通过增加训练图像目标数强化监督;

- 升级:新增Copy-Blend数据增强(仅融合新对象,不覆盖背景),优于Copy-Paste,提升性能。

3.4 训练设置

-

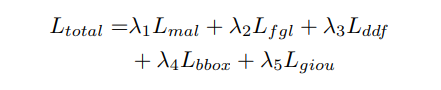

损失函数:总损失为加权和,公式如下:

注:超轻量变体(Pico/Femto/Atto)因容量有限,剔除FGL(细粒度定位损失)与DDF(解耦蒸馏焦点损失)。

-

关键超参数(部分核心参数):

| 超参数 | X | S | Pico | Atto |

|---|---|---|---|---|

| 输入分辨率 | 640 | 640 | 640 | 320 |

| 训练轮次(Epochs) | 50 | 120 | 468 | 468 |

| 基础学习率(Base LR) | 5e-4 | 5e-4 | 1.6e-3 | 2e-3 |

| Copy-Blend概率 | 0.5 | 0.5 | 0.0 | 0.0 |

4. 实验结果

4.1 中大型变体性能(对比SOTA)

| 模型 | #参数(M) | GFLOPs | latency(ms) | AP | 优势 |

|---|---|---|---|---|---|

| DEIMv2-X | 50.26 | 151.6 | 13.75 | 57.8 | 超DEIM-X(62M参数、56.5 AP),参数少19%,AP高1.3 |

| DEIMv2-L | 32.18 | 96.32 | 10.47 | 56.0 | 超YOLOv12-L-turbo(27M参数、54.0 AP),AP高2.0 |

| DEIMv2-M | 18.11 | 52.20 | 8.80 | 53.0 | 超D-FINE-M(19M参数、52.3 AP),参数少4.7%,AP高0.7 |

| DEIMv2-S | 9.71 | 25.62 | 5.78 | 50.9 | 首个亚10M模型突破50 AP,超DEIM-S(10M参数、49.0 AP) |

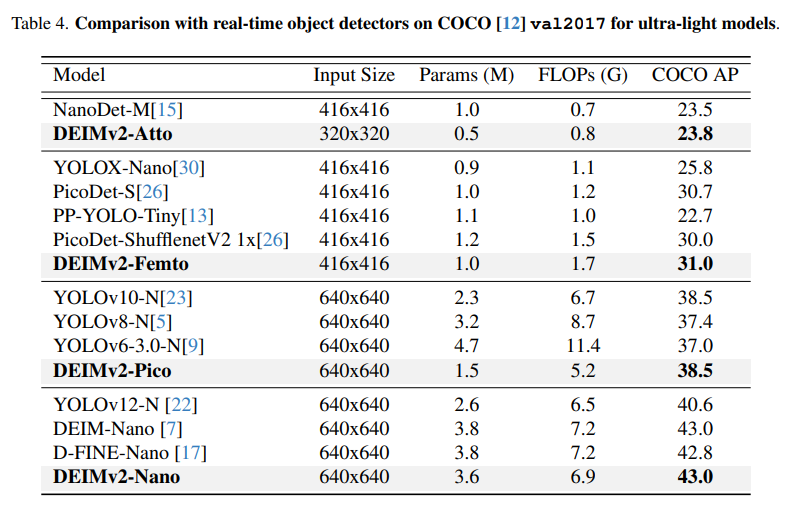

4.2 超轻量变体性能(对比SOTA)

| 模型 | #参数(M) | GFLOPs | AP | 对比优势 |

|---|---|---|---|---|

| DEIMv2-Nano | 3.57 | 6.86 | 43.0 | 与D-FINE超轻量模型相当,参数更优 |

| DEIMv2-Pico | 1.51 | 5.15 | 38.5 | 匹配YOLOv10-Nano(2.3M参数、38.5 AP),参数减少约50% |

| DEIMv2-Femto | 0.96 | 1.67 | 31.0 | 参数不足1M,适配极端资源约束场景 |

| DEIMv2-Atto | 0.49 | 0.76 | 23.8 | 最小变体,参数仅0.49M,满足移动设备极限需求 |

5. 核心贡献与结论

- 贡献1:提出覆盖全尺度部署的DEIMv2,8种模型适配GPU、边缘及移动设备;

- 贡献2:中大型变体用DINOv3+STA优化特征利用,超轻量变体剪枝HGNetv2满足资源约束;

- 贡献3:简化解码器与增强Dense O2O,进一步提升性能-效率比;

- 结论:DEIMv2在COCO数据集全场景超越现有SOTA实时检测器,为不同硬件部署提供高效解决方案,推动实时目标检测实用化。

好了,这篇文章就介绍到这里,喜欢的小伙伴感谢给点个赞和关注,更多精彩内容持续更新~~

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)