【大模型实战】 Qwen2.5-7B大模型部署及使用推理教程(2025版最新最全教程安装)

Qwen2.5-7B 是阿里云发布的大型语言模型,属于 Qwen2.5 系列的一部分。Qwen2.5-7B 以 Apache 2.0 开源协议开源,可以完全免费商用。它在 Hugging Face 上有多个版本可供下载,包括基座版本和指令微调版本。技术规格内容模型类型因果语言模型训练阶段包括预训练和后训练参数总量7.61B(非嵌入层参数:6.53B)注意力头数28(Q)和 4(KV)

【大模型实战】 Qwen2.5-7B大模型下载教程(2025版最新最全教程安装)

1.前言

Qwen2.5-7B 是阿里云发布的大型语言模型,属于 Qwen2.5 系列的一部分。Qwen2.5-7B 以 Apache 2.0 开源协议开源,可以完全免费商用。它在 Hugging Face 上有多个版本可供下载,包括基座版本和指令微调版本。

| 技术规格 | 内 容 |

|---|---|

| 模型类型 | 因果语言模型 |

| 训练阶段 | 包括预训练和后训练 |

| 参数总量 | 7.61B(非嵌入层参数:6.53B) |

| 注意力头数 | 28(Q)和 4(KV) |

Qwen2.5-7B-Instruct 版本是专门为理解和执行指令而设计的,适合用于需要特定功能的应用,如问答、摘要、翻译等任务。它能够准确地解释用户命令,并以更高的准确性和一致性执行任务。

2.部署模型

(1)方法一:使用modelscope库获取

ModelScope 提供了便捷的 API 调用方式,适合在模型库中快速部署

pip install modelscope

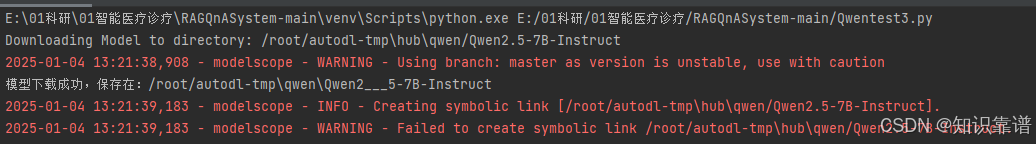

使用 modelscope 库来下载 Qwen2.5-7B-Instruct 模型,并将其保存到指定的目录中

打开PyCharm,运行如下代码块

from modelscope import snapshot_download, AutoModel, AutoTokenizer

try:

model_dir = snapshot_download('qwen/Qwen2.5-7B-Instruct', cache_dir='/root/autodl-tmp', revision='master')

print(f"模型下载成功,保存在:{model_dir}")

except Exception as e:

print(f"模型下载失败:{e}")

(2)方法二:使用Hugging Face获取(经常连接不了网络,不推荐)

打开PyCharm,运行如下代码块

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen2.5-7B-Instruct")

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen2.5-7B-Instruct")

以上代码会自动下载模型权重并缓存到本地

(3)方法三:使用ollama本地部署大模型

3.模型推理

(1)加载本地模型文件

# 加载本地模型文件

from transformers import AutoTokenizer, AutoModelForCausalLM

# 指定本地模型文件路径

model_path = r'E:\root\autodl-tmp\qwen\Qwen2___5-7B-Instruct'

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(model_path)

(2)使用模型进行推理

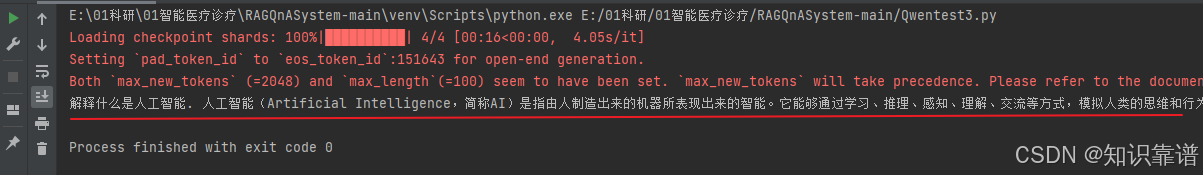

#模型使用

input_text = "解释什么是人工智能."

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs, max_length=100)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)

运行结果如下

至此部署完成,水平有限,如有问题欢迎多做交流!!!

个人网盘链接(30天有效20250104): Qwen2___5-7B-Instruct下载链接 提取码:0782

探讨知识图谱问题,下载所需资源欢迎联系

微信账号: zskp1012

欢迎关注小红书账号:知识靠谱

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)