最近新出的gemini 3 怎么样

Google最新推出的Gemini 3 Pro模型在推理能力、多模态处理和产品集成方面有显著提升。该模型具备更精准的复杂问题解决能力,支持文本、图片、视频等多种输入格式,并增强了编程和自动化任务处理性能。文章还提供了通过API调用Gemini模型的Python代码示例,展示了如何实现问题分析与JSON格式输出。同时介绍了Gemini 2.5系列的稳定版本及其在Google搜索和办公套件中的深度集成

·

最近新出的gemini 3 怎么样

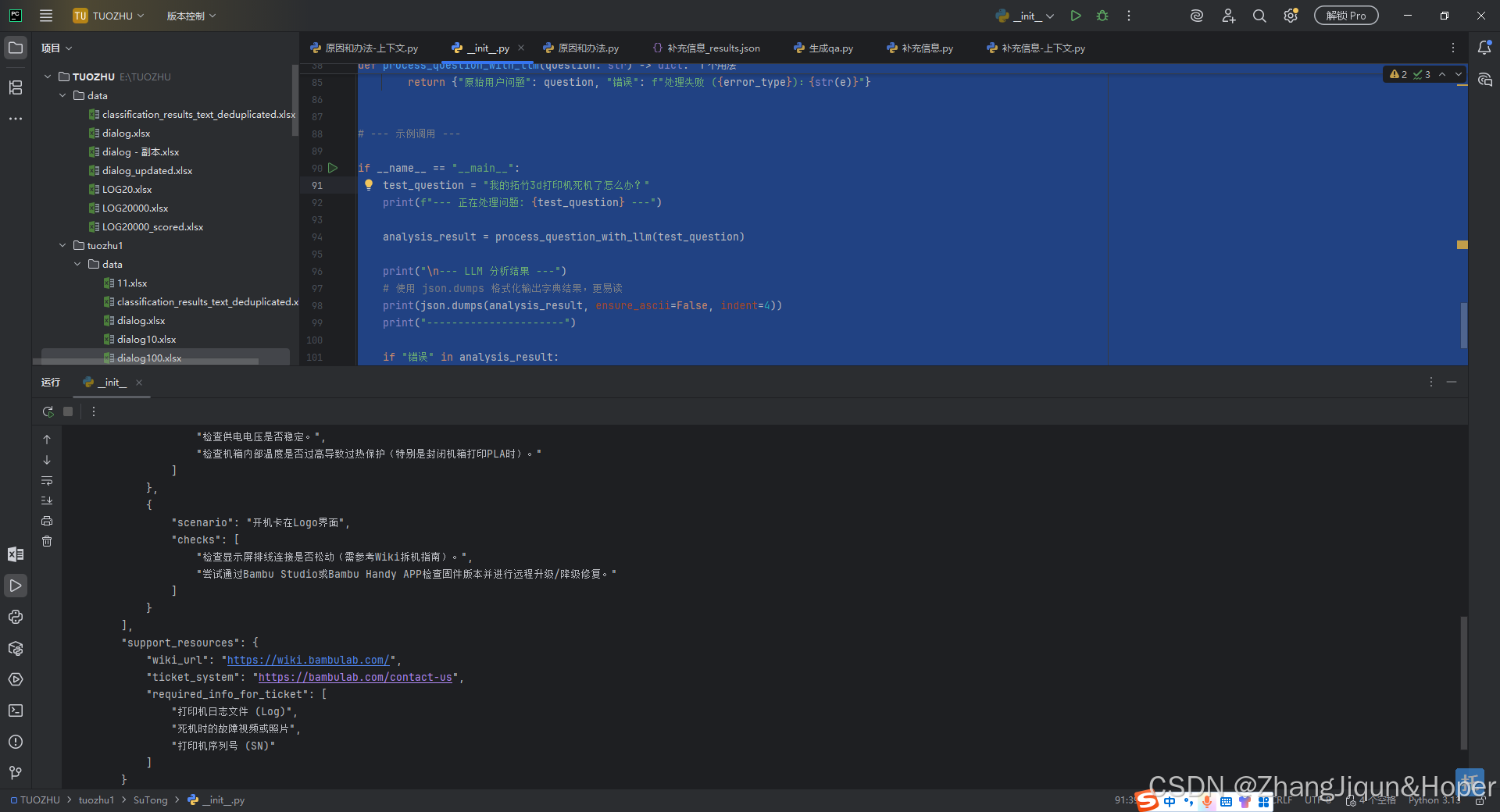

下面是实际的gemin的 Api 接口调用的代码。发现他可以给出链接,虽然所有的网页端的LLM 都有网页检索功能,但是作为API 调用形式的LLM ,我还是头一次遇到。很赞,优秀

🚀 最新旗舰模型:Gemini 3 Pro

Google 在近期(2025 年 11 月)推出了第三代旗舰 AI 模型 Gemini 3.0,尤其是其预览版 Gemini 3 Pro。它被官方称为“最智能”的模型,主要在以下几个方面有显著提升:

- 更先进的推理能力: 能够更精准地掌握内容的深度和细微差异,解决复杂的难题。

- 多模态理解: 具备强大的多模态能力,可以更好地理解和处理文本、图片、视频、音频和 PDF 等多种输入格式。

- Agent (智能体) 和编码能力: 增强了作为智能体的能力,在编程和自动任务处理方面的性能有所跃进。

- 全新的生成式 UI 体验: 在 Google 搜索等应用中,能根据查询生成动态的视觉版面配置、互动式工具和模拟情境。

💡 Gemini 2.5 系列模型的稳定与增强

在 3.0 系列推出之前,Gemini 2.5 系列模型也进行了重要更新,例如:

- Gemini 2.5 Pro (稳定版): 具备自适应思考能力(“Thinking Mode”),即模型会先进行推理再响应,从而生成推理能力更强的回答。

- Gemini 2.5 Flash: 作为首个稳定的 Flash 模型,它是一个低成本、高性能的模型。

🛠️ 应用和开发者生态的深化

Gemini 不仅是一个模型,它也深入集成到 Google 的各种产品和生态中:

- Google 搜索集成: Gemini 3.0 正在逐步增强 Google 搜索的 AI 模式和 AI 摘要功能。

- Google Workspace (办公套件): AI 助理(Gemini)内置于 Gmail、Docs、Slides、Sheets 等,帮助提高工作效率。

- AI 图像生成: 提供了新的图像生成和编辑模型(如 Nano Banana Pro),让用户可以更精准地控制和编辑生成的图像。

- 开发者工具: 提供了新的 API 功能,例如多工具使用(在同一请求中配置代码执行和 Google 搜索)、自定义视频预处理等。

总的来说,最新的 Gemini 模型正在往更智能的推理、更强大的多模态处理,以及更广泛的产品集成方向发展。

完整代码展示

import json

from openai import OpenAI

from openai import APIError, APIConnectionError, Timeout

import os

# --- 配置 ---

# 建议使用环境变量存储 API Key

API_KEY = "sk-JmUHFrwmr4hd1d lZIXrljhsn d7oJ2l3ktkwTvLEG"

# 初始化客户端

client = OpenAI(

base_url="https://api.3 u.com/v1/",

api_key=API_KEY

)

# --- 工具函数 ---

def clean_llm_response(response_content: str) -> str:

"""清理LLM响应,提取标准JSON内容"""

if not response_content or not response_content.strip():

return ""

response_content = response_content.strip()

# 1. 去除代码块标记 (```json/```)

if response_content.startswith("```json"):

response_content = response_content[7:].strip()

if response_content.endswith("```"):

response_content = response_content[:-3].strip()

# 2. 替换中文引号为英文双引号

return response_content.replace("“", "\"").replace("”", "\"").strip()

# --- 核心处理函数 ---

def process_question_with_llm(question: str) -> dict:

"""

使用LLM处理单个问题,根据拓竹专家Prompt进行信息补充、分析。

Args:

question: 原始的用户问题字符串。

Returns:

解析后的 JSON 字典结果,或包含错误信息的字典。

"""

if not question:

return {"错误": "输入问题为空"}

# 完整且严格的 Prompt,确保返回 JSON

prompt = f"""

请根据以下要求处理原始用户问题:"{question}"

"""

cleaned_result = ""

try:

response = client.chat.completions.create(

# 请替换为有效的模型名称

model="gemini-3-pro-preview-thinking-*",

messages=[

{"role": "system", "content": "你是拓竹3D打印专家,仅输出标准JSON,无其他文字。"},

{"role": "user", "content": prompt}

],

timeout=30

)

result = response.choices[0].message.content.strip()

if not result:

return {"原始用户问题": question, "错误": "LLM返回内容为空"}

cleaned_result = clean_llm_response(result)

return json.loads(cleaned_result)

except (APIError, APIConnectionError, Timeout) as e:

error_type = type(e).__name__

return {"原始用户问题": question, "错误": f"API调用失败 ({error_type}):{str(e)}"}

except json.JSONDecodeError as e:

error_type = type(e).__name__

return {"原始用户问题": question,

"错误": f"JSON格式错误 ({error_type}):{str(e)},内容:{cleaned_result[:100]}..."}

except Exception as e:

error_type = type(e).__name__

return {"原始用户问题": question, "错误": f"处理失败 ({error_type}):{str(e)}"}

# --- 示例调用 ---

if __name__ == "__main__":

test_question = "我的拓竹3d打印机死机了怎么办?"

print(f"--- 正在处理问题: {test_question} ---")

analysis_result = process_question_with_llm(test_question)

print("\n--- LLM 分析结果 ---")

# 使用 json.dumps 格式化输出字典结果,更易读

print(json.dumps(analysis_result, ensure_ascii=False, indent=4))

print("----------------------")

if "错误" in analysis_result:

print("\n**注意:API调用或解析失败,请检查模型名称和API Key**")

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)