Spring AI:本地安装 Ollama 并运行 Qwen3 模型

Spring AI:本地安装 Ollama 并运行 Qwen3 模型

Spring AI 如何对接大模型的教程:

Spring AI:对接DeepSeek实战

Spring AI:对接官方 DeepSeek-R1 模型 —— 实现推理效果

Spring AI:ChatClient实现对话效果

Spring AI:使用 Advisor 组件 - 打印请求大模型出入参日志

Spring AI:ChatMemory 实现聊天记忆功能

目前,我们已经成功对接了官方的 DeepSeek 大模型,本文中,我们尝试在本地电脑上,通过 Ollama 部署一个大模型来使用。

什么是 Ollama?

Ollama 是一个开源工具,专注于 在本地计算机上运行、部署和管理大型语言模型(LLM)。它的核心目标是让用户能够轻松地在自己的笔记本电脑或工作站上运行诸如 DeepSeek-R1、Qwen3、Llama 3 等先进的 AI 模型,而无需依赖云服务或复杂的配置。

其优势如下:

- 极简的本地运行体验: 提供 Windows、macOS 和 Linux 的安装包,安装过程非常简单。安装完成后,只需一条命令即可下载并运行模型,无需繁琐的环境配置或依赖管理。

- 强大的模型支持: 官方支持并优化了众多热门开源模型。

- 本地化与隐私保护: 模型下载到本地后,所有的推理计算都在你的电脑上进行,完全离线运行。并且,你与模型的对话、提示词、生成的文本等所有数据都保留在你的机器上,不会上传到云端,对于处理敏感信息或注重隐私的用户至关重要。

- 易于管理和更新: 使用简单的命令 (ollama list, ollama pull, ollama rm) 即可查看已安装模型、下载新模型、删除旧模型。可以方便地更新已安装的模型到最新版本 (ollama pull <模型名>)。

- 提供 API 接口: Ollama 在本地运行时会启动一个 HTTP 服务器(默认端口 11434),提供与 OpenAI API 兼容的 API 接口 (/v1/chat/completions, /v1/embeddings)。

- 活跃的社区: 作为一个开源项目,Ollama 拥有快速增长且活跃的社区,不断有新的模型被适配、新的功能被提出和实现,以及丰富的讨论和教程资源。

下载 Ollama

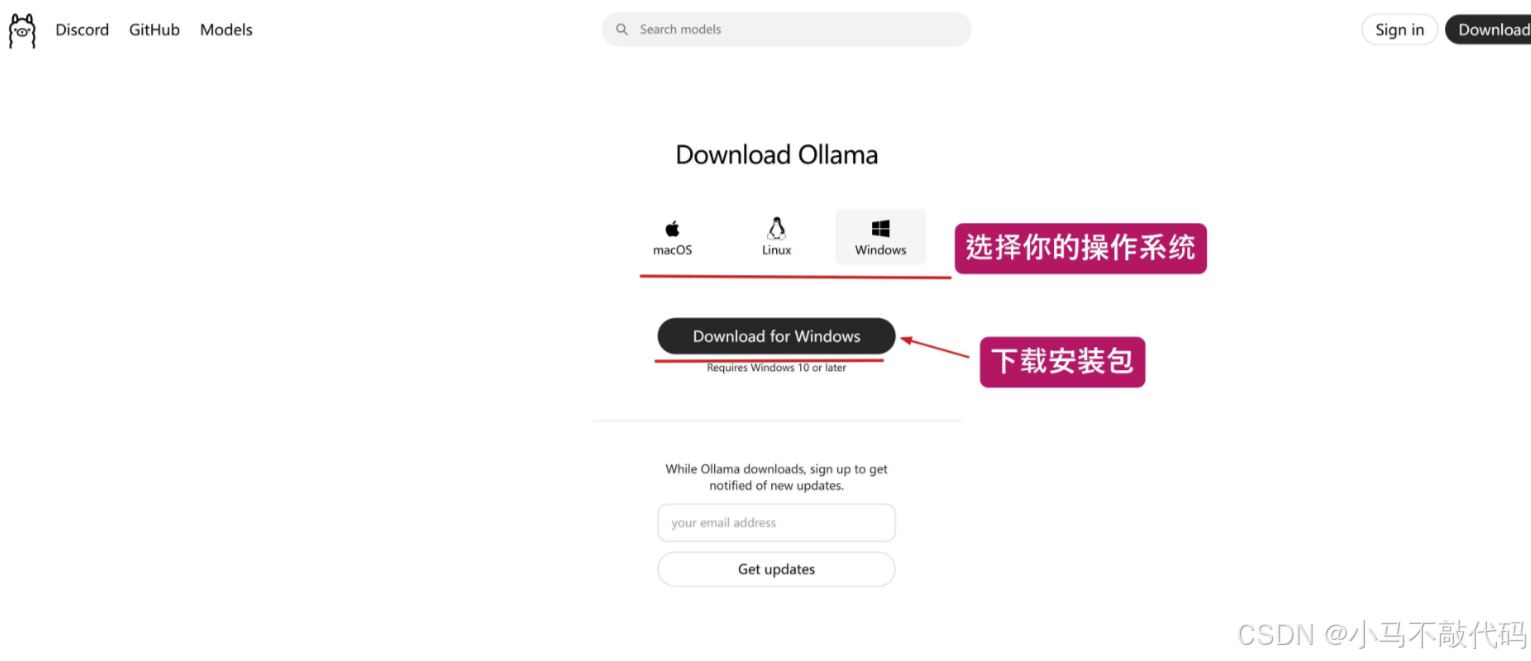

打开浏览器,访问 Ollama 官方下载链接:https://ollama.com/download ,如下图所示,选择你的操作系统类型,并点击下方的下载按钮,开始下载安装包,我这里使用的是 Windows 系统:

安装 Ollama

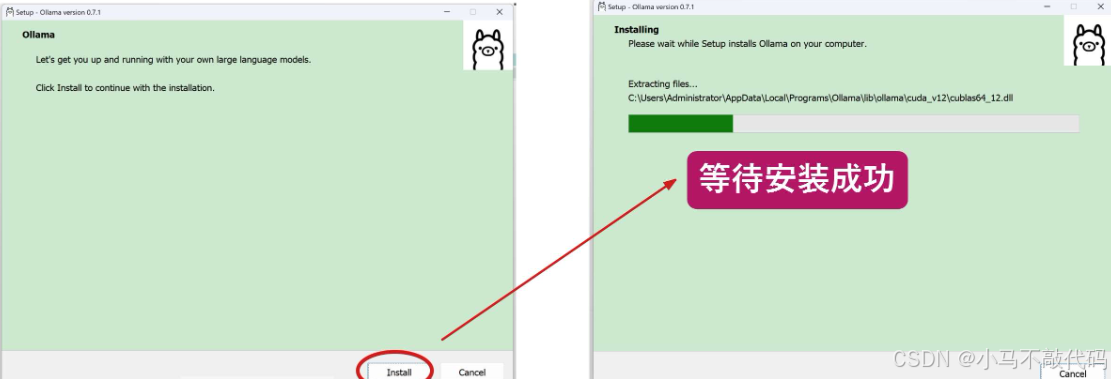

安装包下载完毕后,双击 .exe 文件:

点击 Install 按钮开始安装,注意,Ollama 目前不支持自定义安装路径,默认会安装在 C 盘下:

安装完成后,如果是 Win 11 系统,右下角会弹出提示 “Ollama is runing”,提醒我们 Ollama 目前正在运行中:

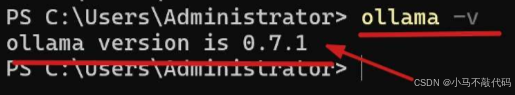

打开 CMD 命令行工具,输入命令 ollama -v , 如果能够打印 Ollama 的版本号,说明确实是安装成功了:

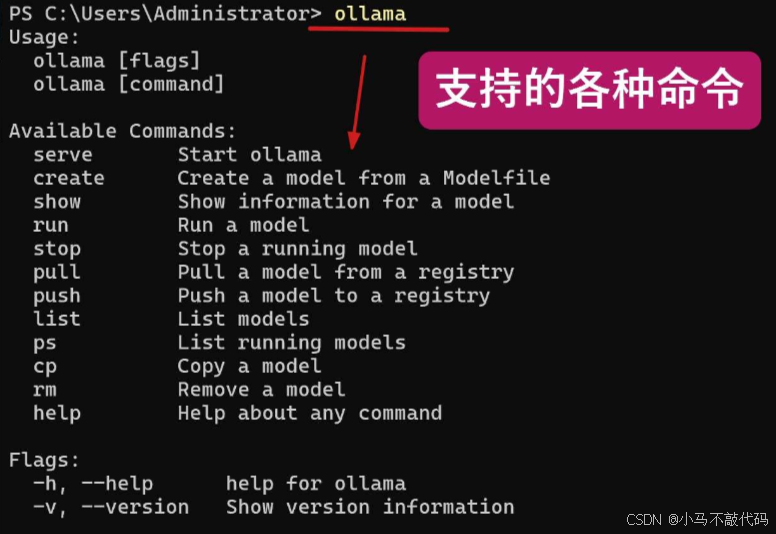

Ollama 支持的命令

当我们在命令行中,直接输入 ollama 时,会列出它支持的所有命令,如下图所示:

解释一下上述命令各自的作用:

ollama serve: 启动 Ollama 后台服务,首次安装后需启动服务才能使用其他命令(通常自动运行),默认启动在端口11434 上;

ollama run <模型名>:下载并运行指定模型,进入交互式聊天界面;

ollama stop:停止当前运行的模型;

ollama pull <模型名>:下载模型到本地(不运行);

ollama list:查看所有已下载的本地模型,包含模型名称、大小、更新时间;

ollama rm <模型名>:删除本地模型释放空间;

ollama creat:创建自定义的模型;

ollama show <模型名>:查看模型配置信息;

ollama cp <源模型> <新名称>:复制模型并重命名;

ollama ps:查看正在运行的模型进程;

ollama push <用户名/模型名>:将自定义模型发布到 Ollama 仓库;

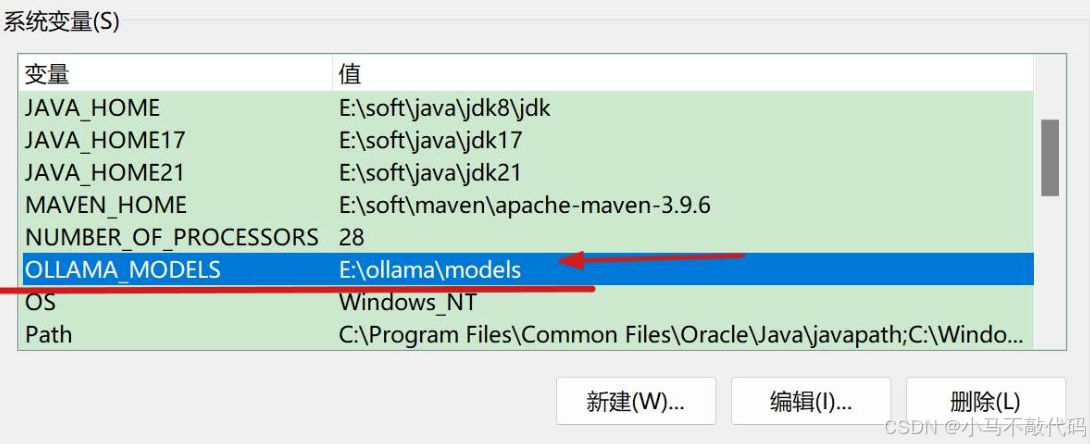

更改模型存放位置

在 Windows 系统中,通过 Ollama 下载的模型,会默认存放在 C 盘下,具体路径为 C:\Users%username%.ollama\models , 考虑到 C 盘是系统盘,通常磁盘空间很小,并且模型一般体积较大,我们需要更改一下大模型存放的位置。

只需编辑系统变量,如下图所示,添加系统变量 OLLAMA_MODELS , 值填写想存放的位置,我这里是放到了 E:\ 盘下:

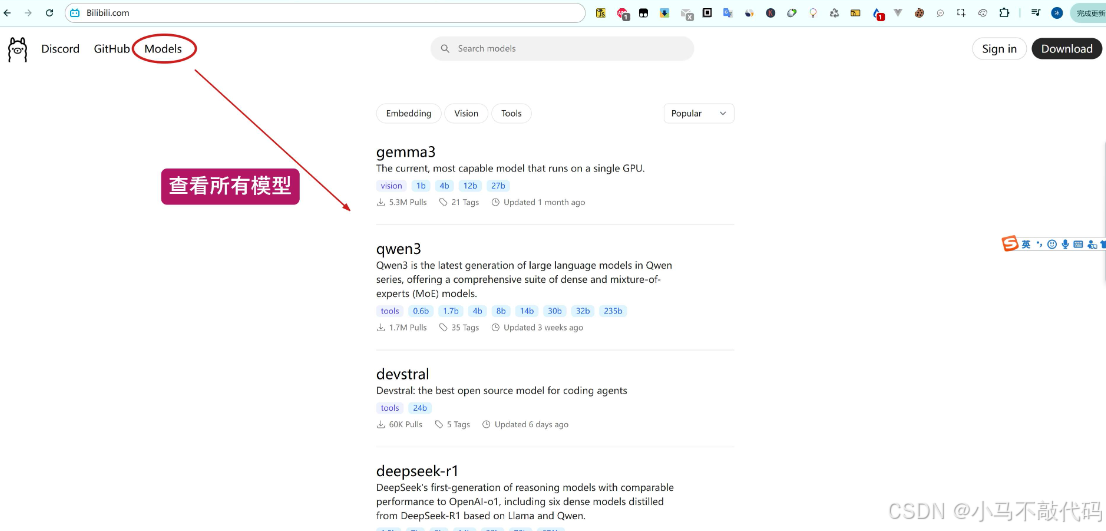

下载并运行千问 3 模型

Ollama 安装完成后,接下来,我们尝试下载一个大模型并运行看看。小伙伴们可以登录到 Ollama 的官网:https://ollama.com/ ,点击上方的 Models , 即可查看流行的大模型,如千问3,DeepSeek-R1 等等

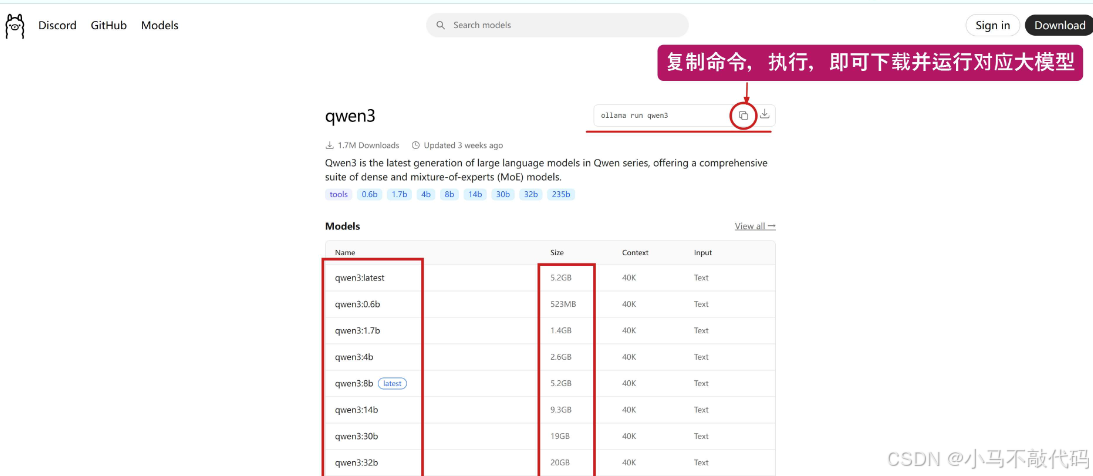

我们下载并运行一个千问 3 模型耍耍,看看效果咋样,访问地址:https://ollama.com/library/qwen3 ,进入详情页中,如下图,右上方可以复制对应 Ollama 命令,运行该命令,即可下载模型并运行:

简介:

千问3(Qwen3)是阿里巴巴在 2025 年 4 月发布的新一代通义千问大模型系列,凭借开创性的技术架构与全球领先的性能,登顶 “全球最强开源模型” 宝座。

同时,千问 3 也提供了不同尺寸的模型,如 0.6b、1.7b、…、到 235b, 根据你显卡的显存来决定下载哪个,体积越大,当然模型质量更高,回答效果越好。

我的显卡有 16G 显存,所以,根据 size 体积,我的电脑最大能流畅运行 14b 的模型,执行如下命令即可。至于 30b 需要占用 19G, 已经超出我的显存大小了。

ollama run qwen3:14b

ollama run qwen3:1.7b

运行模型

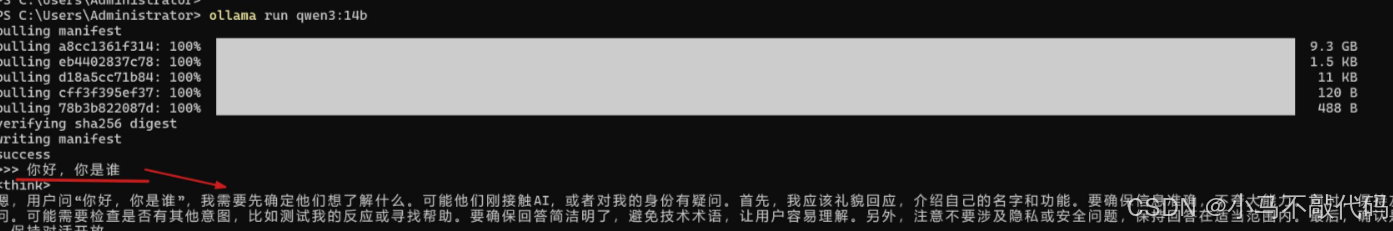

ollama run 命令用于运行模型,如果本地没有该模型,则会先执行下载,下载完成后,自动会将模型运行起来:

等待千问 3 模型下载完成后,在命令中,提问 “你好,你是谁”,回答效果如上图所示,可以看到,模型运行成功啦!

TIP: 要想停止运行当前大模型,只需按住快捷键 ctrl + d 即可。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)