深度解析:大模型 A2A (Agent2Agent) 协议——当 AI 开始“开会”协作

深度解析:大模型 A2A (Agent2Agent) 协议——当 AI 开始“开会”协作

📖 前言

在过去的一年里,我们习惯了 User-to-Agent (U2A) 的模式:人类输入提示词(Prompt),ChatGPT 回复。但随着任务变得越来越复杂(例如开发一个完整的游戏、撰写长篇研报),单个 Agent(智能体)往往力不从心。

于是,Multi-Agent System (多智能体系统) 爆发了。当一个 AI 扮演产品经理,另一个扮演程序员,还有一个扮演测试工程师,它们之间如何沟通?如何传递上下文?如何避免“吵架”?

这就引出了今天的核心——Agent2Agent (A2A) 交互协议。本文将带你深入理解 AI 之间是如何“社交”的。

🏗️ 什么是 A2A (Agent2Agent)?

A2A (Agent2Agent) 指的是两个或多个自主智能体(Autonomous Agents)之间进行信息交换、任务分配、协作求解的通信机制。

如果说 API 是程序之间的接口,那么 A2A 就是“大脑”与“大脑”之间的语言。

核心区别

| 模式 | 参与者 | 交互介质 | 典型场景 |

|---|---|---|---|

| User2Agent (U2A) | 人 ↔ AI | 自然语言 (Prompt) | 问答、翻译、闲聊 |

| Agent2Tool (A2T) | AI ↔ 工具 | API / JSON | 联网搜索、查数据库、调 Python |

| Agent2Agent (A2A) | AI ↔ AI | 结构化指令 + 自然语言 | 复杂项目开发、辩论、模拟社会 |

🎨 A2A 的通信架构图解

为了让 AI 协同工作,它们不能只是在大喊大叫,需要遵循一定的“协议”或“流程”。常见的 A2A 拓扑结构有以下几种:

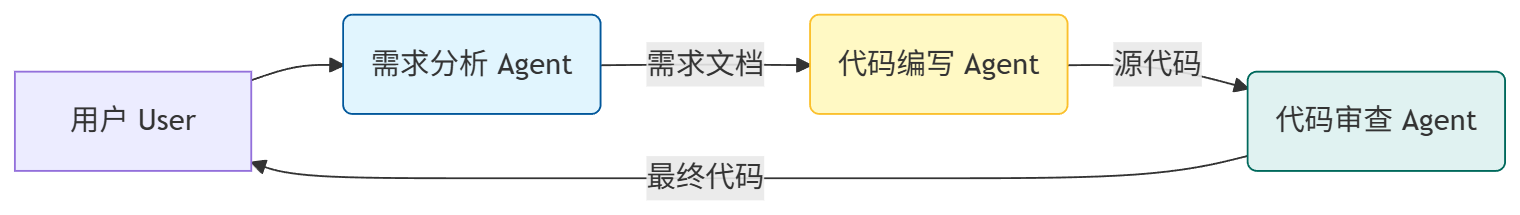

1. 链式协作 (Sequential Handoff)

像接力赛一样,上一个 Agent 的输出是下一个 Agent 的输入。

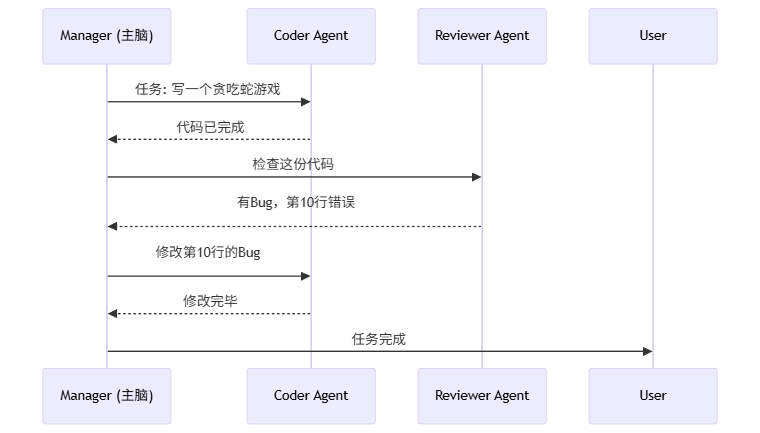

2. 集中式调度 (Centralized Manager)

类似于公司里的“项目经理”,有一个主 Agent 负责分发任务和汇总。

⚙️ A2A 协议的核心要素

虽然目前业界还没有一个像 HTTP 那样统一的 A2A 标准(RFC),但在 AutoGen、MetaGPT、CrewAI 等框架中,A2A 协议通常包含以下四个核心部分:

1. 角色定义 (Role Profile)

AI 必须知道“我是谁”以及“你是谁”。

- System Prompt:定义人设(如:“你是一个资深 Python 工程师,只输出代码,不废话”)。

- Capability:定义能力边界(如:能否联网、能否执行代码)。

2. 消息总线 (Message Bus)

Agent 之间传递的信息通常包含:

{

"sender": "Product_Manager",

"receiver": "Software_Engineer",

"content": "请根据需求文档编写登录接口。",

"context": { "history_summary": "...", "files": ["req.txt"] },

"state": "PENDING_REVIEW"

}

3. 终止条件 (Termination Condition)

两个 AI 聊天可能会陷入死循环(互相客套)。A2A 协议必须定义何时结束:

- 关键词触发:如出现 “TERMINATE”。

- 迭代次数:最多对话 10 轮。

- 任务状态:单元测试通过。

4. 人类介入 (Human-in-the-loop)

A2A 协议通常允许人类在关键节点“插嘴”或审批,充当超级 Agent。

💻 代码实战:基于 AutoGen 的 A2A

微软的 AutoGen 是目前实现 A2A 模式最流行的框架。下面我们演示一个 “程序员 Agent” 和 “代码审查员 Agent” 协作写代码的例子。

1. 环境准备

pip install pyautogen

2. 编写代码

import os

from autogen import AssistantAgent, UserProxyAgent

# 配置 LLM (这里假设你本地有模型或使用 OpenAI/DeepSeek API)

config_list = [

{

"model": "gpt-4",

"api_key": "YOUR_API_KEY"

}

]

# 1. 定义角色:Cathy (程序员)

cathy = AssistantAgent(

name="Cathy",

llm_config={"config_list": config_list},

system_message="你是一个高级Python工程师。编写代码解决用户的问题。如果代码需要修改,请根据反馈进行修改。"

)

# 2. 定义角色:Bob (代码审查员/产品经理)

# UserProxyAgent 可以代表人类,也可以自动执行代码并反馈结果给 Cathy

bob = UserProxyAgent(

name="Bob",

human_input_mode="NEVER", # 不让人类插手,全自动

max_consecutive_auto_reply=10, # 最多自动回复10次

is_termination_msg=lambda x: "TERMINATE" in x.get("content", ""),

code_execution_config={"work_dir": "coding", "use_docker": False}, # 允许执行代码

system_message="你负责审查代码并运行。如果代码运行报错,将错误信息反馈给Cathy。如果运行成功,回复 TERMINATE。"

)

# 3. 启动 A2A 对话

task = "帮我写一个 Python 脚本,获取当前股票市场 NVDA 的价格,并画出最近5天的趋势图保存为 stock.png"

bob.initiate_chat(

cathy, # Bob 发起对话,对象是 Cathy

message=task

)

3. 运行过程解析 (模拟日志)

- Bob (UserProxy): 发送任务给 Cathy。

- Cathy (Agent): 思考后,生成一段 Python 代码(使用

yfinance库)。 - Bob (UserProxy): 自动捕获代码 -> 在本地运行 -> 发现报错(比如缺少

yfinance库)。 - Bob (A2A Feedback): 将报错信息 “ModuleNotFoundError: No module named ‘yfinance’” 发回给 Cathy。

- Cathy (Agent): 接收错误 -> 思考 -> 回复:“抱歉,我们需要先安装库。这是修正后的代码,包含 pip install…”。

- Bob (UserProxy): 再次运行 -> 成功生成

stock.png-> 回复 “TERMINATE”。 - 对话结束。

这就是一个标准的 A2A 闭环!

🧐 为什么 A2A 是大模型的未来?

1. 突破 Context Window (上下文窗口) 限制

单个 Agent 如果要把整个项目的代码都读进去,上下文很容易爆。A2A 可以让不同的 Agent 只关注自己的模块,通过精简的接口文档沟通。

2. 减少幻觉 (Hallucination)

“Reviewer” 模式已被证明极其有效。一个模型生成的代码可能有错,但另一个模型(或同一个模型换个身份)去检查它时,往往能发现错误。

3. 专业化分工 (Specialization)

你可以让一个 Agent 挂载法律知识库,另一个挂载医学知识库。当遇到医疗纠纷问题时,让它们协作,比训练一个全能模型更高效、成本更低。

🔮 现有的 A2A 协议/标准

虽然没有统一标准,但以下项目正在定义 A2A 的事实标准:

- AutoGen (Microsoft): 基于“对话流”的协议,极其灵活。

- MetaGPT: 基于“SOP (标准作业程序)”的协议,模仿软件公司的流程。

- The Agent Protocol (AI Engineer Foundation): 试图定义通用的 API 接口(

/agent/tasks),让不同框架的 Agent 能互联。 - MCP (Model Context Protocol): Anthropic 最近推出的协议,重点在于 Agent 如何连接数据源和工具,是 A2A 生态的重要基石。

📝 总结

A2A 协议让大模型从 “聊天机器人” 进化为 “数字员工”。

- 以前:你是一个指令,AI 执行一个动作。

- 现在:你给出一个目标,Agent 团队(A2A)自行拆解、规划、执行、纠错,最后交付结果。

如果你正在构建 AI 应用,请停止把所有逻辑塞进一个 Prompt 里,尝试把任务拆分,让多个 Agent 协作,你会发现新大陆!

喜欢这篇文章吗? 欢迎点赞、收藏、关注我的 CSDN 博客,获取更多大模型实战干货! 🚀

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)