大模型(像 ChatGPT、Claude、Gemini 之类)响应结果每次可能不一致

大模型不是一个固定的“程序输出”,而是一个带随机性的“概率分布采样器”。如果需要。

·

这是个很好的问题 👍。

大模型(像 ChatGPT、Claude、Gemini 之类)响应结果每次可能不一致,主要原因有以下几点:

1. 生成机制是概率性的

- 大模型的本质是预测“下一个词出现的概率分布”。

- 当有多种合理答案时,模型会根据概率随机采样。

- 所以,即使同样的输入,每次也可能选到不同的词,最终回答有差异。

👉 这就是“随机性”的来源。

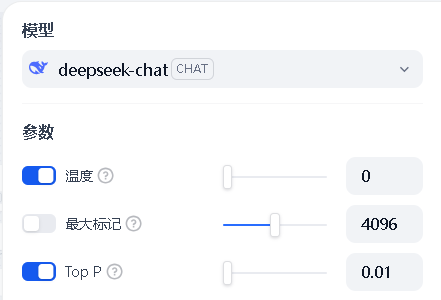

2. 温度(Temperature)参数

- 温度越高(如 0.8、1.0),模型输出更有创造性,随机性大,结果差异明显。

- 温度越低(如 0 或 0.1),模型会更确定,更倾向于选概率最大的答案,结果更稳定。

3. Top-k / Top-p 采样策略

- Top-k:限制模型只从概率前 k 个候选词里选。

- Top-p(核采样):只从累积概率达到 p 的词中选。

- 这两种采样策略都会影响输出多样性。

4. 上下文与隐含因素

- 对话历史、提示词的细微差别都会影响结果。

- 甚至同一问题,在不同会话里可能得到不同回答。

5. 模型更新

- 有时平台会更新模型或训练数据,导致同样的问题在不同时间点得到的答案不同。

✅ 总结

大模型不是一个固定的“程序输出”,而是一个带随机性的“概率分布采样器”。如果需要结果稳定:

- 可以调低 温度(甚至设为 0)。

- 在 API 里固定 随机种子(seed),这样每次采样路径一致,输出就稳定了。

好,我来举个直观的例子 🚀

我们提同样的问题:

“写一句关于早晨的句子。”

🌡️ 温度高(temperature = 1.0)

模型会更有创造性,答案可能五花八门:

- “清晨的阳光像金色的羽毛,轻轻落在屋顶。”

- “鸟儿在黎明的微风里唱着不知名的歌。”

- “天边泛起一抹粉红,好像谁泼洒了一杯桃汁。”

👉 句子都正确,但风格差异很大。

🌡️ 温度低(temperature = 0 或 0.1)

模型几乎总是选择概率最高、最常见的表达:

- “早晨的太阳从东方升起。”

- (如果重复问多次,大概率还是类似的常见句子)

👉 输出更稳定,但少了创造力。

✅ 总结

- 高温度 → 多样化,适合创意写作、头脑风暴。

- 低温度 → 稳定可靠,适合事实性、标准化输出(比如代码、公式、翻译)。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)