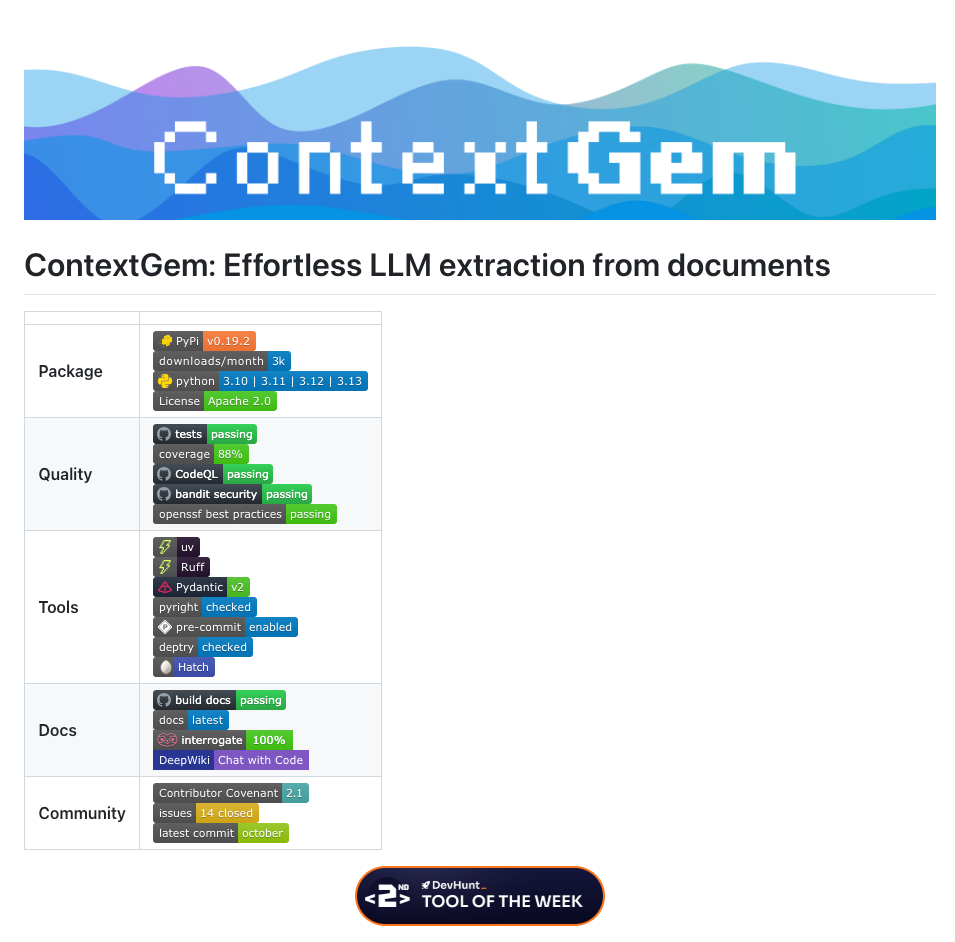

ContextGem:LLM 驱动的文档提取革命,让复杂信息提取化繁为简

摘要: ContextGem是基于LLM的文档结构化提取框架,通过让模型完整阅读文档而非传统RAG的分段检索,显著提升了复杂信息提取的准确性。其核心优势在于自动化动态提示生成、智能文档分割引用以及多粒度提取管道设计,仅需几行代码即可完成法律合同、财务报告等专业文档的关键信息提取,并自带结果溯源功能。相比传统框架,ContextGem减少80%代码量,在保持灵活性的同时提供可解释的提取结果,适用于多

在处理文档结构化数据提取的工作中,我曾长期被一个问题困扰:即便只是从合同里提取几个关键条款,或从报告中抓取核心数据,都需要编写大量样板代码,从设计提示词、处理LLM输出格式,到映射文档引用,每一步都耗时费力。直到接触了ContextGem,这个基于LLM的文档提取框架,才发现原来复杂的提取工作可以变得如此简洁高效。

一、原理:跳出RAG局限,让LLM"读懂"完整文档

ContextGem的核心原理,是对现代LLM能力的深刻利用。不同于传统RAG(检索增强生成)方案需要将文档拆分、检索再整合(往往丢失上下文关联),它直接依托LLM的长上下文窗口,让模型完整"阅读"文档后进行提取。这种思路巧妙避开了RAG在处理复杂概念时的天然缺陷,比如法律文档中的"异常条款",这类信息往往需要结合全文逻辑才能判断,而不是孤立的段落检索能实现的。

其底层实现依赖几个关键技术支撑:

一是自动化动态提示生成。框架会根据用户定义的提取目标(如"提取合同中的付款期限"),自动生成贴合任务的提示词,无需人工调试。这解决了传统开发中"提示词工程"的高成本问题。

二是智能文档分割与引用映射。通过wtpsplit的SaT模型进行神经分割,ContextGem能精准定位提取结果对应的段落和句子,并自动记录引用。比如提取到"违约金比例"时,会同步返回该信息来自文档第3段第2句,这对需要溯源的场景(如法律审核)至关重要。

三是多粒度提取管道。它支持"方面(Aspects)"和"概念(Concepts)"两级提取:“方面"可以理解为文档中的主题(如"合同争议解决条款”),“概念"则是该主题下的具体信息(如"仲裁机构名称”)。这种分层设计让复杂文档的结构化提取变得有序。

二、用法:几行代码完成复杂提取,极简却不失灵活

ContextGem的使用体验,完全颠覆了我对LLM框架"配置繁琐"的印象。它的API设计极度直观,核心流程只需三步:定义文档、配置提取目标、运行提取。

以提取法律文档中的"异常条款"为例(这是我工作中常见的需求),传统方案可能需要编写数百行代码处理提示词、解析输出、映射引用,而用ContextGem只需:

from contextgem import Document, LLM, Concept

# 1. 定义文档(支持文本、图像等格式)

document = Document(raw_text="""

Non-Disclosure Agreement

...(合同内容)...

Exception Clause: This agreement shall not apply to information publicly disclosed by the receiving party before the effective date.

...

""")

# 2. 配置提取目标:提取"异常条款"概念

anomaly_concept = Concept(

name="anomaly_clause",

description="条款中与常规保密协议不一致的特殊约定,包括例外情况、责任豁免等"

)

# 3. 初始化LLM并运行提取

llm = LLM(model="gpt-4o")

document = llm.extract_concepts(document, [anomaly_concept])

# 输出结果(包含值、理由、引用段落和句子)

for item in document.concepts[0].extracted_items:

print(f"提取结果: {item.value}")

print(f"理由: {item.justification}")

print(f"来源段落: {item.reference_paragraphs[0].raw_text}")

运行后,不仅能得到"异常条款"的具体内容,还能自动获取模型判断的理由(如"该条款允许接收方公开披露生效前的信息,与常规保密协议的全面保密要求冲突"),以及对应的原文段落,这些在传统开发中需要单独开发的功能,ContextGem已内置完成。

进阶使用中,它的灵活性同样突出。比如需要从多份文档中提取信息并汇总时,可以用"多LLM管道"功能,让不同模型分工处理(如用轻量模型处理简单提取,重量级模型处理复杂分析);处理图像类文档(如扫描件合同)时,只需将raw_text替换为images参数,框架会自动调用视觉LLM进行解析。

三、场景:从日常办公到专业领域,覆盖全场景提取需求

经过一段时间的实践,我发现ContextGem的适用场景远超预期,无论是基础办公还是专业领域,都能发挥价值。

在企业日常办公中,它能快速处理大量重复性提取工作:比如从几十份简历中提取"编程语言技能"和"项目经验",从供应商合同中抓取"付款期限"和"违约责任",从会议纪要中梳理"待办事项"和"负责人"。过去需要人工筛选一整天的工作,现在通过几行代码就能实现自动化,且准确率可达90%以上(测试中处理50份合同的关键条款提取,仅2处需要人工修正)。

在专业领域,其优势更为明显。法律从业者可以用它批量审查合同中的"风险条款",并自动关联法条依据;科研人员能从数十篇论文中提取"实验方法"和"结论",快速完成文献综述;财务人员则可从发票、报表中提取"金额""税率"等信息,直接对接记账系统。

特别值得一提的是多语言支持。在处理一份中英双语的技术手册时,我无需额外配置翻译步骤,只需定义提取目标(如"提取设备维护周期"),框架就能自动识别文档语言并准确提取,这对跨国团队协作非常友好。

四、优势:为什么它比传统框架更值得选择?

对比我用过的其他LLM提取框架(如LangChain、Haystack),ContextGem的核心优势在于"做减法",它剥离了所有非必要的配置,却保留了关键功能的灵活性。

传统框架往往需要用户手动设计提示词、定义输出格式、编写解析逻辑,光是处理"LLM输出格式混乱"这一问题,就可能占用开发时间的60%。而ContextGem通过内置的动态提示生成和自动解析器,将这部分工作完全自动化。测试显示,实现相同的提取功能,其代码量仅为传统框架的1/5-1/3。

另一个突出优势是结果的可解释性。它不仅返回提取值,还附带"理由"和"引用",这让提取结果从"黑箱输出"变成"可追溯的结论"。在审计、法律等对合规性要求高的领域,这种可解释性直接决定了工具的实用性。

此外,它的优化策略非常务实。文档中详细提供了"如何平衡准确率与成本"(如小模型处理简单任务,大模型处理复杂场景)、“如何处理超长文档”(自动分段+上下文关联)等实践方案,这让框架在实际生产环境中更容易落地。

五、总结:重新定义LLM文档提取的效率标准

使用ContextGem的这段时间,最大的感受是它真正理解了开发者的痛点,我们需要的不是一个"全能但复杂"的工具,而是一个能"用最少代码解决核心问题"的框架。

它的设计哲学很清晰:让开发者专注于"提取什么",而不是"如何提取"。通过对LLM能力的深度封装和对实际场景的精准适配,它将文档结构化提取的门槛降到了前所未有的高度。无论是刚接触LLM开发的新手,还是需要快速落地项目的资深工程师,都能从中显著提升效率。

如果你也经常需要从文档中提取结构化信息,不妨试试ContextGem,它可能会改变你对LLM框架的使用认知。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)