2025年未来网络发展大会:AI大模型跨域训练池化调度技术体系白皮书

该白皮书由紫金山实验室等单位编制,围绕 AI 大模型跨域训练展开,分析行业现状与技术路线,提出创新技术体系并验证评估,为实现全国一体化算力网提供技术路径。全局池化调度:适用于企业大模型后训练,通过统一抽象 “三异” 资源,提供无差别使用,构建算力网生态,实现 “像用水用电一样用算”。跨广域的算网存协同调度:管控层协同任务、数据、流量调度,资源层提供算力、存储、网络管控,实现资源协同匹配和动态分配。

该白皮书由紫金山实验室等单位编制,围绕 AI 大模型跨域训练展开,分析行业现状与技术路线,提出创新技术体系并验证评估,为实现全国一体化算力网提供技术路径。

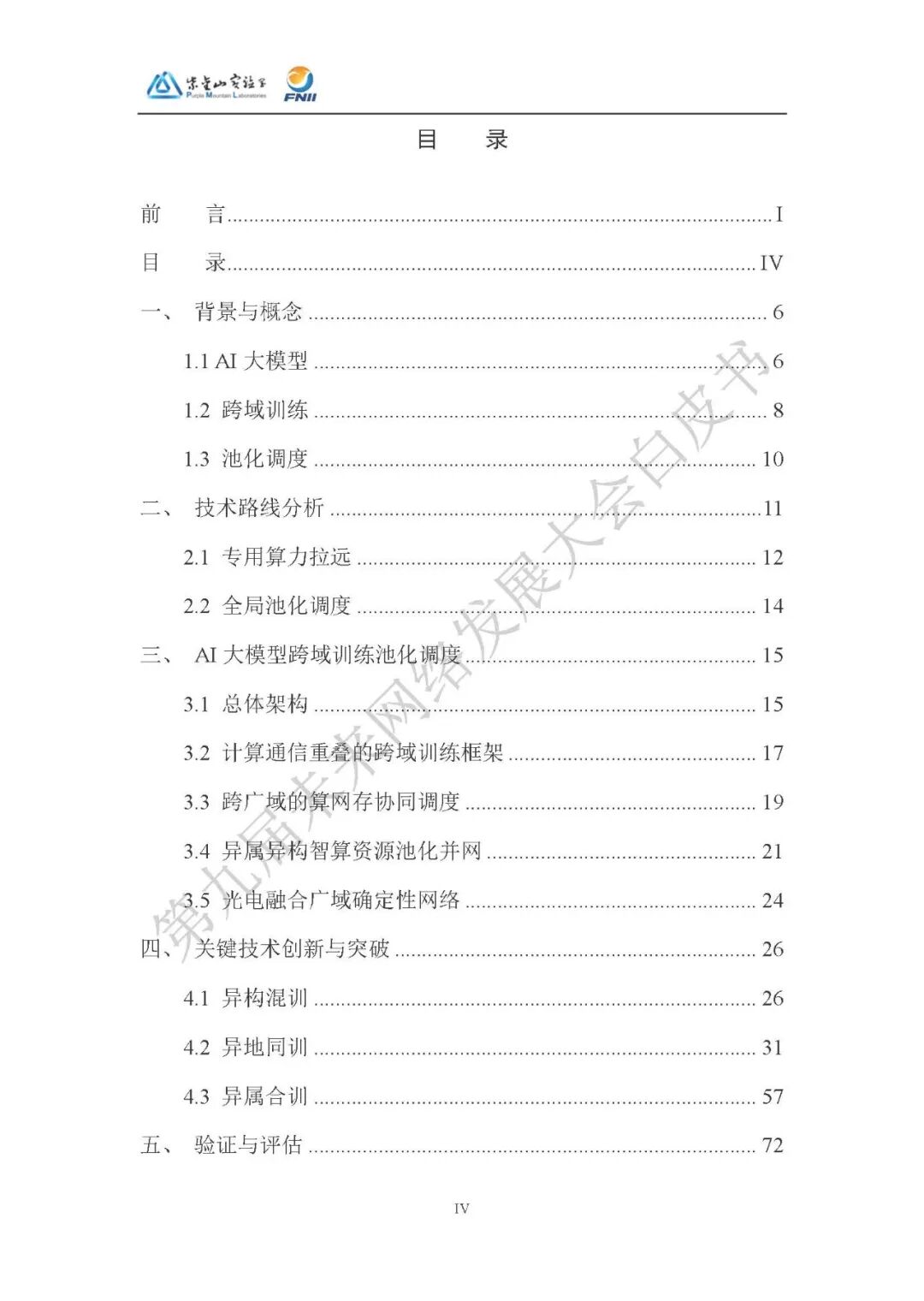

1、背景与概念

AI 大模型参数量达万亿至十万亿级,训练需大量 GPU 资源 ,其发展推动从通用大模型向行业大模型转型,企业大模型后训练需求增长。我国算力规模大,但高端智能算力 “少、杂、散”,跨域训练面临异属、异构、异地挑战。当前算力调度模式多样,算力网调度是未来发展方向,但 “三异” 资源封装抽象仍在探索。

2、技术路线分析

专用算力拉远:面向通用大模型,通过特定智算中心点对点互联,实现单集群本地训练的 “环境复刻”,但不考虑算力网生态模式。

全局池化调度:适用于企业大模型后训练,通过统一抽象 “三异” 资源,提供无差别使用,构建算力网生态,实现 “像用水用电一样用算”。

3、AI 大模型跨域训练池化调度技术体系

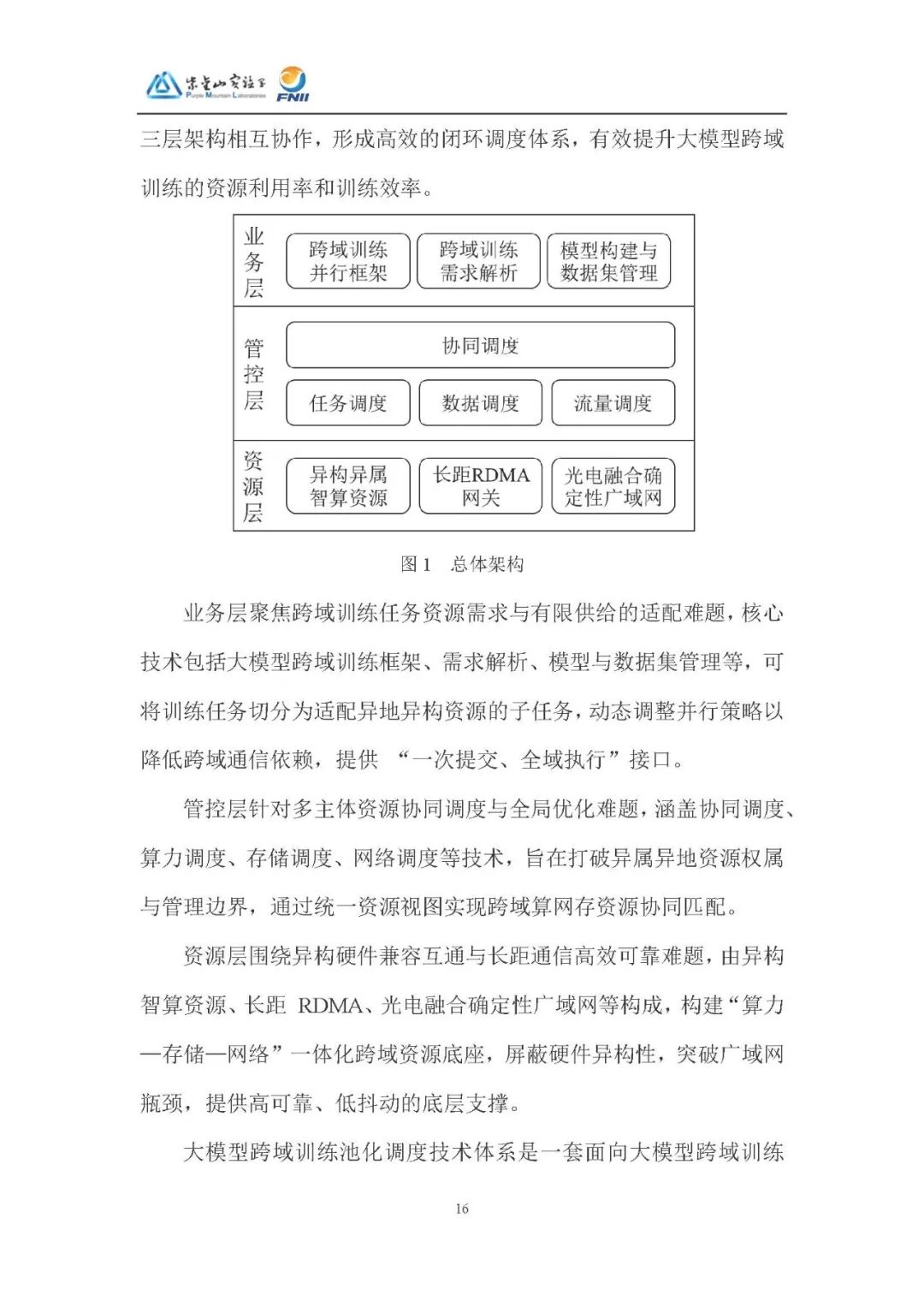

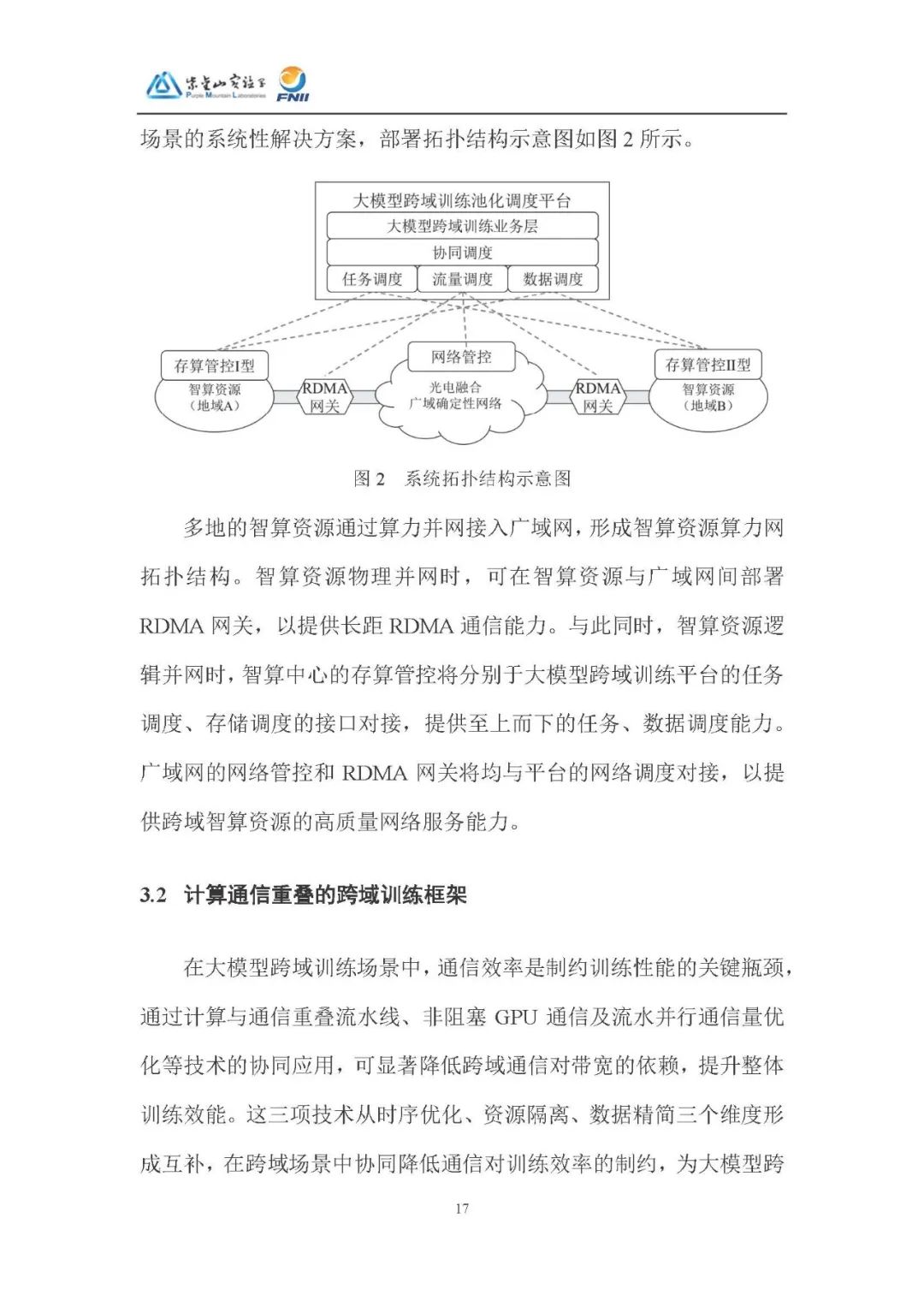

总体架构:采用分层解耦设计,业务层接收任务并转化,管控层协同调度资源,资源层整合异构计算资源,三层协作形成闭环调度体系。

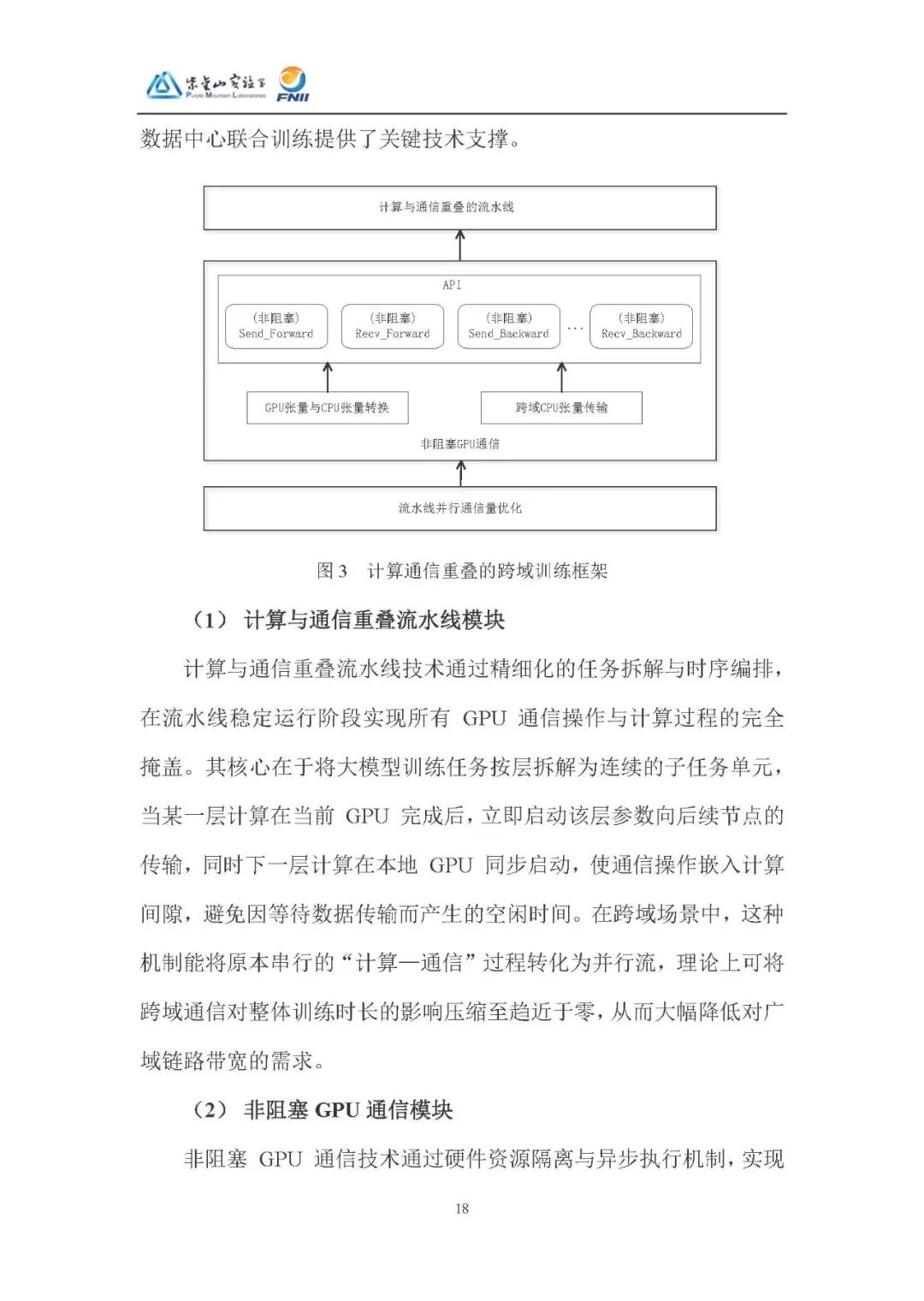

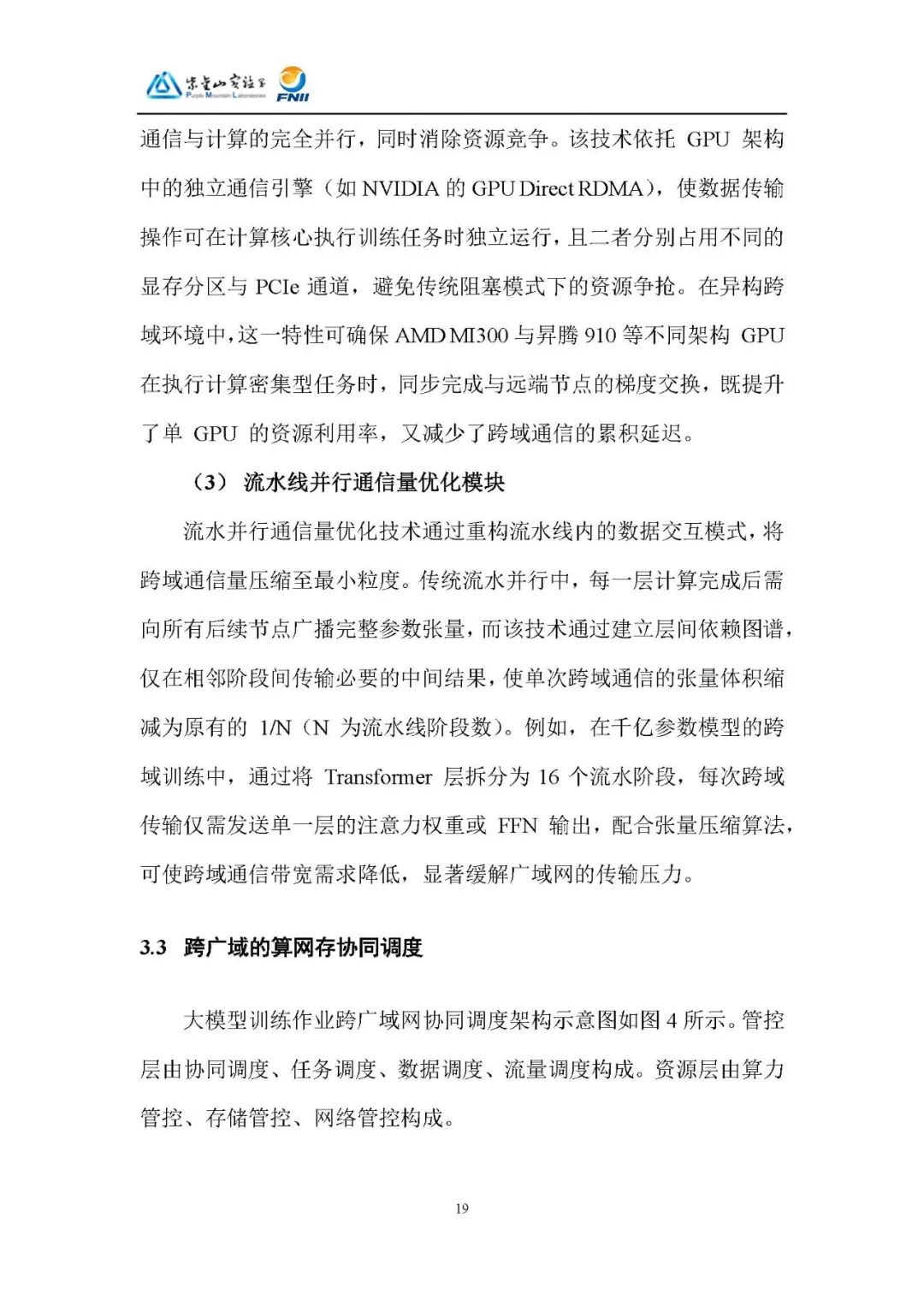

计算通信重叠的跨域训练框架:通过计算与通信重叠流水线、非阻塞 GPU 通信、流水并行通信量优化等技术,降低跨域通信对带宽的依赖,提升训练效能。

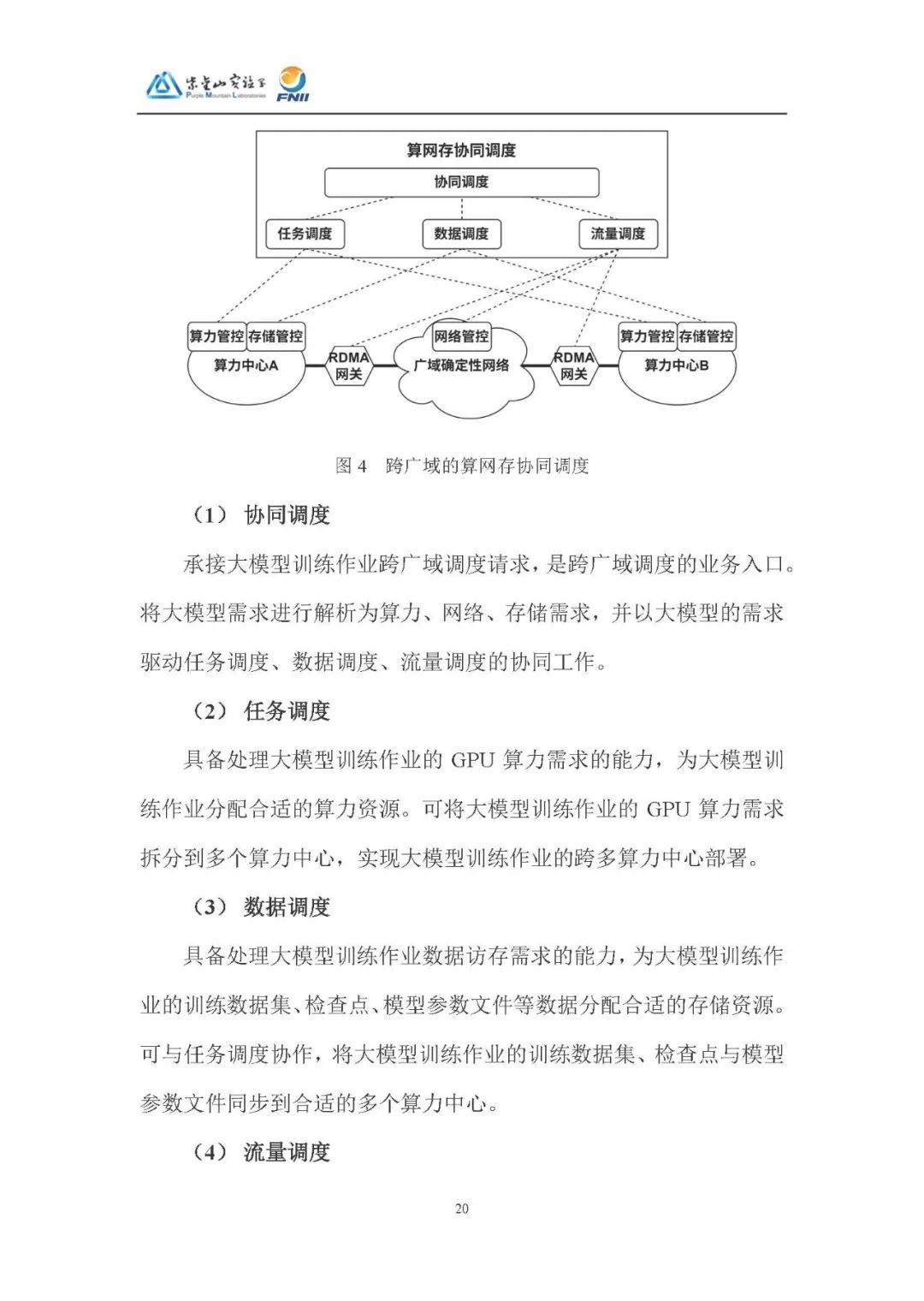

跨广域的算网存协同调度:管控层协同任务、数据、流量调度,资源层提供算力、存储、网络管控,实现资源协同匹配和动态分配。

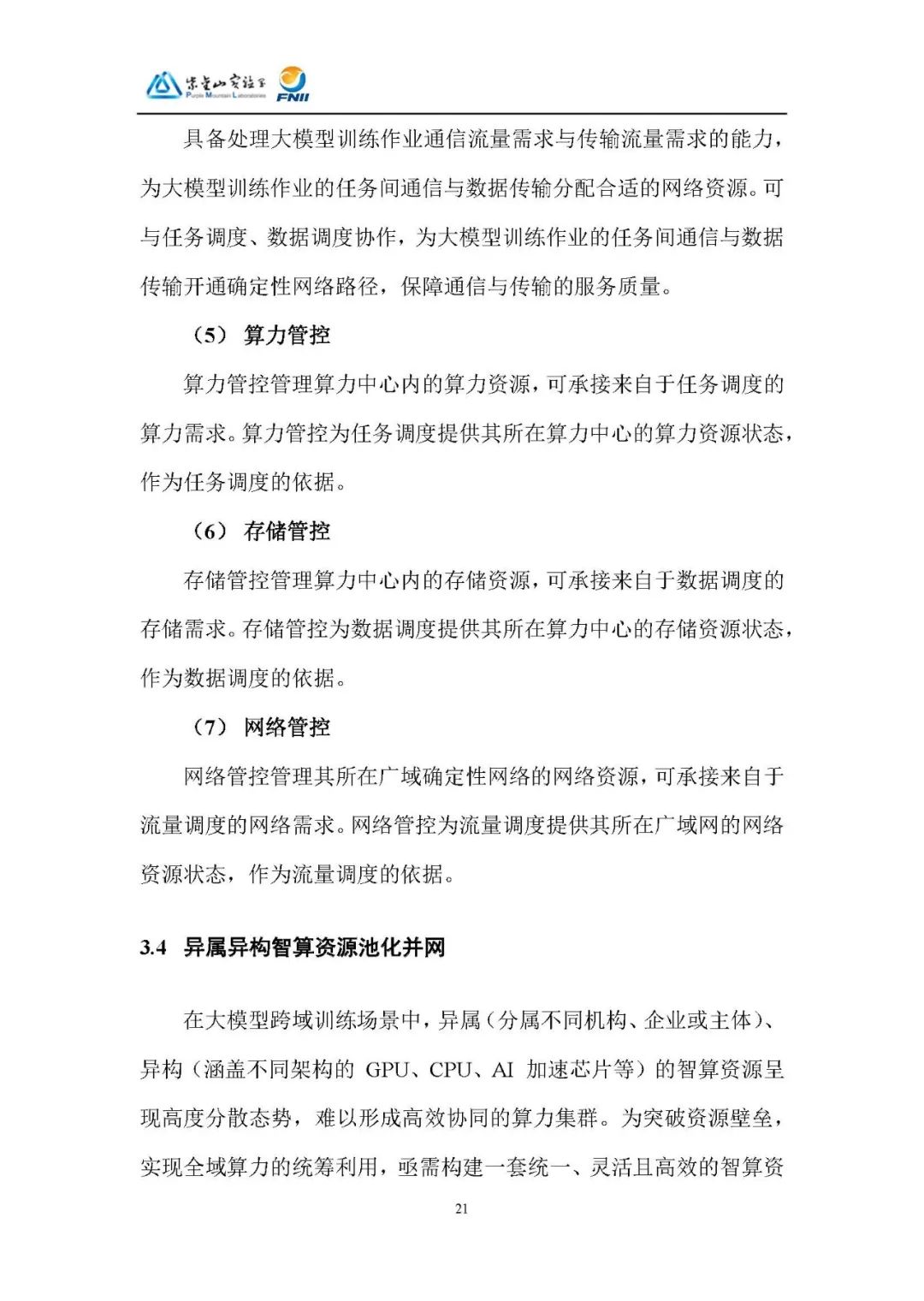

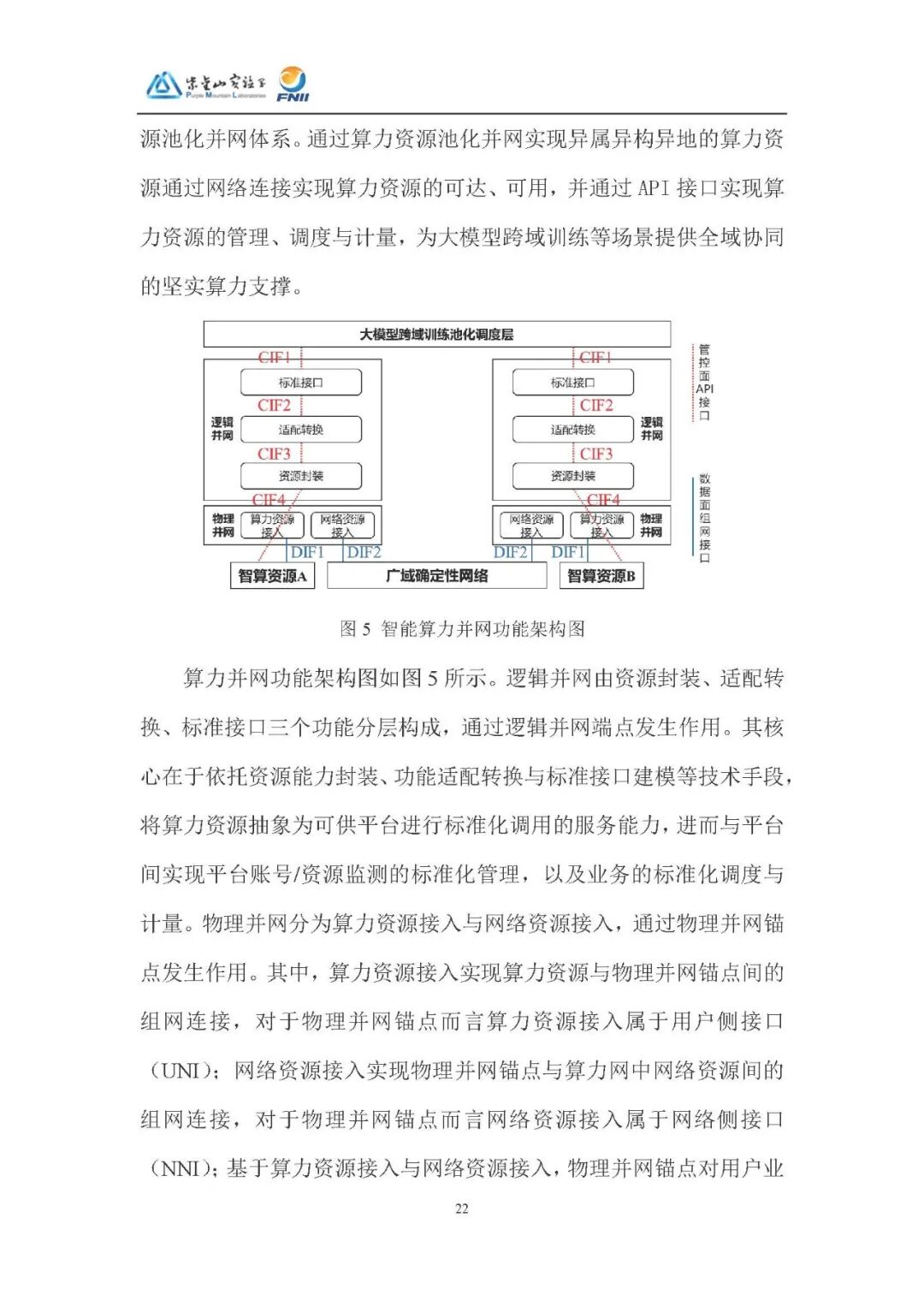

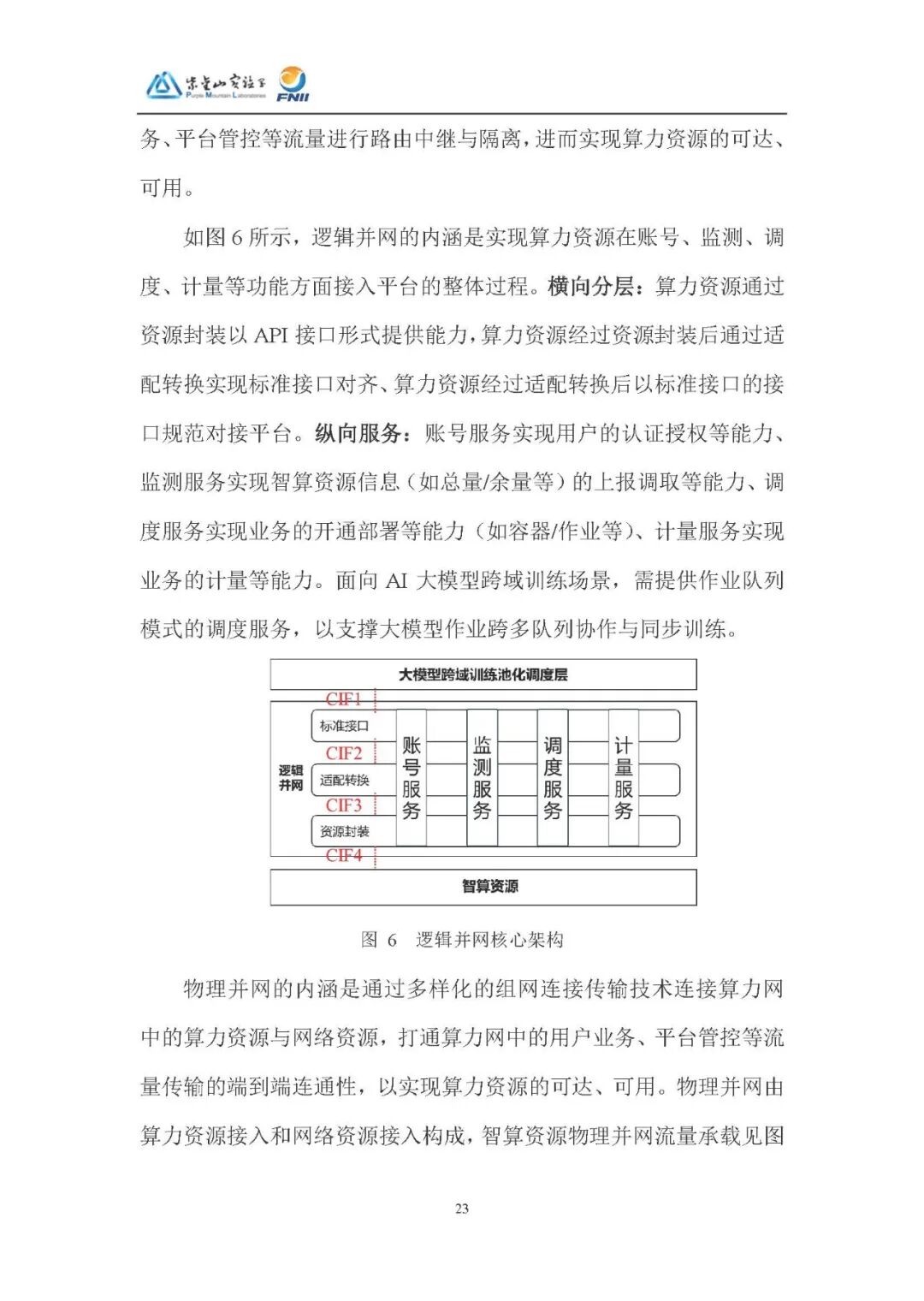

异属异构智算资源池化并网:通过逻辑并网和物理并网,实现算力资源的统一接入、管理和调度,为跨域训练提供支撑。

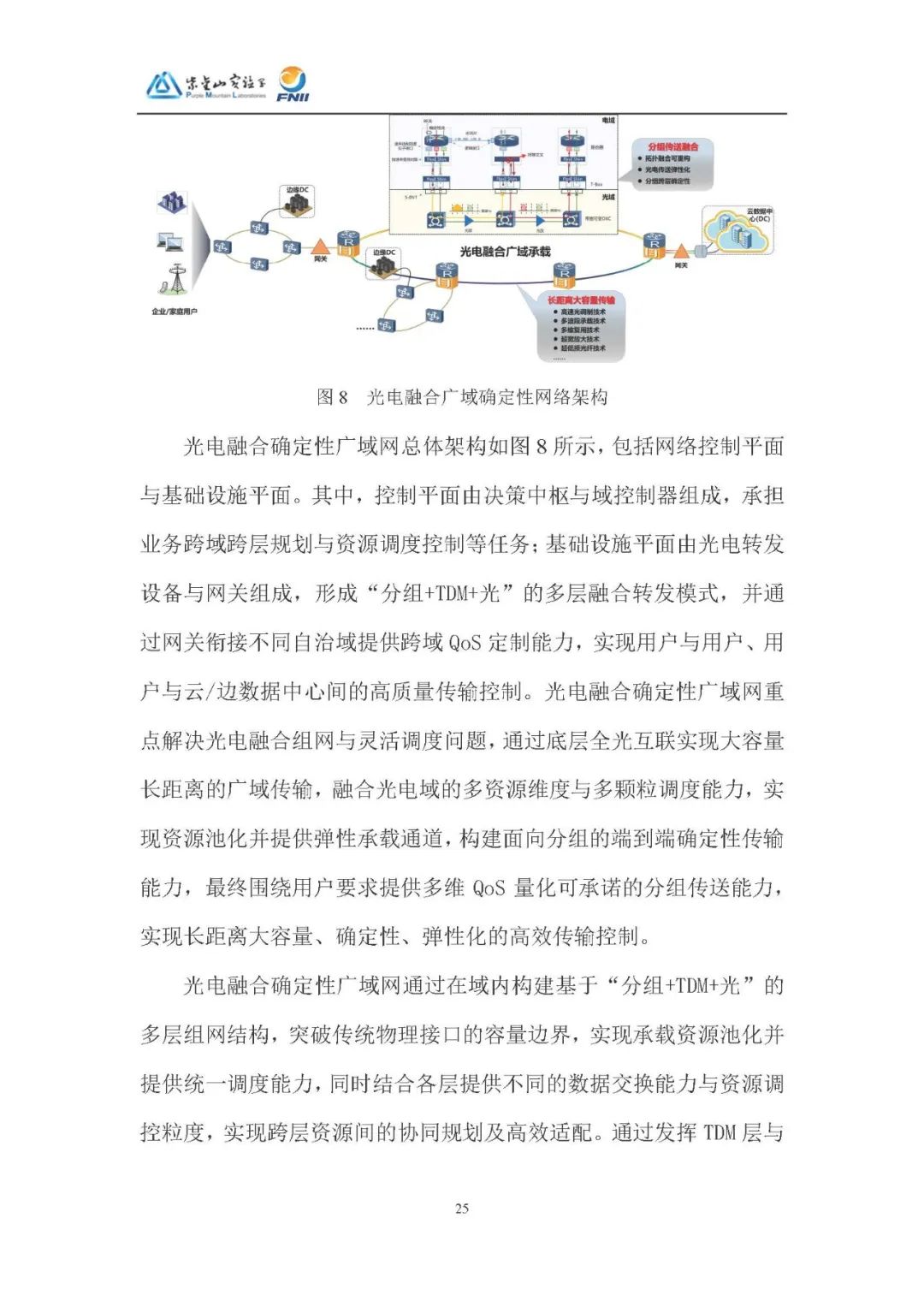

光电融合广域确定性网络:解决光传送与数通融合问题,提供大容量、低延迟、确定性的网络服务,满足大模型跨域训练需求。

4、关键技术创新与突破

异构混训:基于算力特征分层拆解模型,动态生成适配镜像,实现不同架构 GPU 协同训练,提升训练效率和资源利用率。

异地同训:采用计算通信重叠流水线、非阻塞 GPU 通信等技术,降低网络带宽和延迟对训练的影响,提高 GPU 算力利用率。

异属合训:通过多队列排队协作和联合抢占技术,解决多主体、多队列场景下大模型训练作业协同调度难题,提升跨域训练效率。

验证与评估:构建包含异属异构异地三个算力集群和一个总控集群的试验环境,通过多个训练任务对技术体系的各项能力进行验证。结果表明,该技术体系在异属算力集群协同训练、广域确定性网络传输、算网协同调度等方面表现良好,能有效提升跨域训练效率。

5、总结与展望

该技术体系实现了 “异属合训、异构混训、异地同训” 的池化调度能力,为全国一体化算力网提供技术支撑。未来将朝着算力泛在化、效率本地化、生态开放化方向发展,推动 AI 大模型训练技术进步 。

点击文后阅读原文,可获得下载资料的方法。

欢迎加入智能交通技术群!扫码进入。

点击文后阅读原文,可获得下载资料的方法。

联系方式:微信号18515441838

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)