LoRA:大模型参数高效微调技术详解,5分钟掌握核心原理

LoRA是一种参数高效微调(PEFT)技术,通过低秩矩阵分解解决大模型微调的计算和存储成本问题。它冻结预训练模型参数,只训练低秩矩阵增量,显著降低训练开销。LoRA适用于GPT、LLaMA等大语言模型和视觉Transformer,支持多任务切换和高效推理,特别适合算力受限环境。

LoRA是一种参数高效微调(PEFT)技术,通过低秩矩阵分解解决大模型微调的计算和存储成本问题。它冻结预训练模型参数,只训练低秩矩阵增量,显著降低训练开销。LoRA适用于GPT、LLaMA等大语言模型和视觉Transformer,支持多任务切换和高效推理,特别适合算力受限环境。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

本文建议阅读时长:5分钟

随着大规模 Transformer 模型(如 GPT、LLaMA、ViT)的广泛应用,微调大模型的计算和存储成本成为制约因素。LoRA 作为一种参数高效微调(PEFT)技术,通过低秩矩阵分解,仅微调增量部分,有效降低了资源消耗。

本文将分步骤解析 LoRA 的训练原理及优势,帮助你快速掌握 LoRA 的核心机制。

一、LoRA 简介

LoRA(Low-Rank Adaptation)是一种针对大模型的参数高效微调方法,核心思想是:

·冻结大部分预训练模型参数,只在低秩矩阵上进行增量训练,显著降低训练和存储成本;

·适用于大语言模型(LLM)、视觉 Transformer(ViT)及其他大规模深度模型。

二、LoRA 训练详细步骤

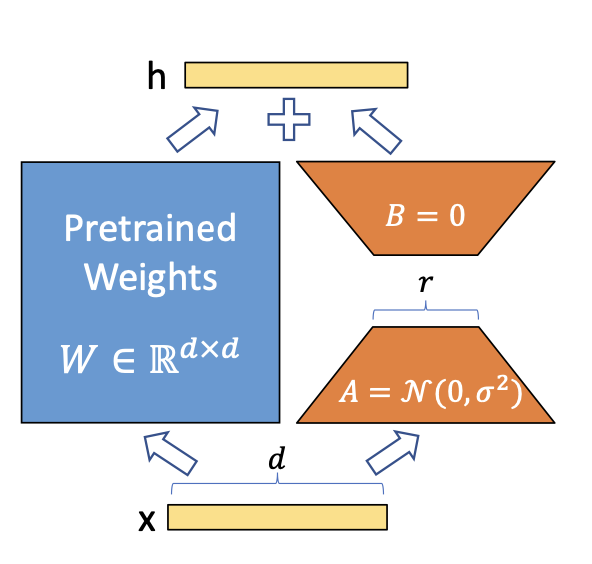

1. 冻结预训练模型参数

传统微调需调整整个 Transformer 权重,而 LoRA 只冻结原模型参数,避免全量反向传播开销。

for param in model.parameters():

param.requires_grad = False # 冻结所有参数

优点:显著降低训练计算和显存需求。

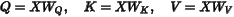

2. 替换 Transformer 注意力层的全连接层

Transformer 中,查询(Q)、键(K)、值(V)计算通常通过线性层实现:

LoRA 不直接训练原始权重  ,而是对其增量进行低秩分解:

,而是对其增量进行低秩分解:

其中:

· 大小为

大小为  (低秩矩阵),

(低秩矩阵),

· 大小为

大小为

· ,大幅减少训练参数。

,大幅减少训练参数。

代码示例:

import torch.nn as nn

class LoRALinear(nn.Module):

def __init__(self, in_features, out_features, rank=4, alpha=32):

super().__init__()

self.rank = rank

self.alpha = alpha

self.W = nn.Linear(in_features, out_features, bias=False)

self.W.requires_grad_(False) # 冻结原权重

self.A = nn.Linear(in_features, rank, bias=False) # d × r

self.B = nn.Linear(rank, out_features, bias=False) # r × d

nn.init.kaiming_uniform_(self.A.weight, a=5**0.5)

nn.init.zeros_(self.B.weight) # B 零初始化,防止扰动原始权重

def forward(self, x):

return self.W(x) + self.alpha * self.B(self.A(x))

3. 只训练低秩矩阵参数

optimizer = torch.optim.AdamW([

{'params': model.lora_A.parameters()},

{'params': model.lora_B.parameters()}

], lr=1e-4)

仅训练  和

和  ,冻结原模型所有参数,显著降低计算量。

,冻结原模型所有参数,显著降低计算量。

4. 训练完成后权重合并

训练完成后,可将增量权重直接加到原始权重:

合并优势:

·推理时无额外计算开销;

·轻松部署,无需保留额外参数结构。

5. 推理阶段选择

·保持 LoRA 结构:适合多任务动态切换,节省存储;

·合并权重:适合单一任务高效推理,避免额外计算。

示例合并代码:

model.W_Q.weight.data += model.B.weight @ model.A.weight

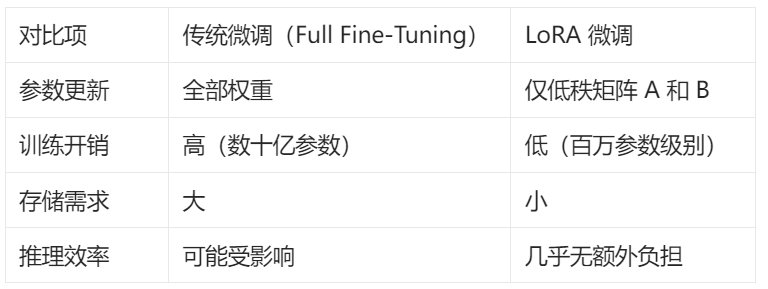

三、LoRA 与传统微调对比

LoRA 特别适合:

·大规模 Transformer 微调(如 GPT、LLaMA、ViT);

·多任务模型快速切换与存储优化;

·算力受限环境,如移动端和边缘计算。

四、LoRA 在 Transformer 中的作用位置

LoRA 主要作用于 Multi-Head Attention 的查询(Q)、键(K)、值(V)线性层,是微调最关键的参数部分。

五、LoRA 训练示例代码

import torch

import torch.nn as nn

import torch.optim as optim

class LoRAModel(nn.Module):

def __init__(self, d, r=4, alpha=32):

super().__init__()

self.W = nn.Linear(d, d, bias=False)

self.W.requires_grad_(False)

self.A = nn.Linear(d, r, bias=False)

self.B = nn.Linear(r, d, bias=False)

nn.init.kaiming_uniform_(self.A.weight, a=5**0.5)

nn.init.zeros_(self.B.weight)

self.alpha = alpha

def forward(self, x):

return self.W(x) + self.alpha * self.B(self.A(x))

model = LoRAModel(d=512, r=4).cuda()

optimizer = optim.AdamW([

{'params': model.A.parameters()},

{'params': model.B.parameters()}

], lr=1e-4)

for epoch in range(10):

x = torch.randn(32, 512).cuda()

y = model(x).sum()

y.backward()

optimizer.step()

optimizer.zero_grad()

print(f"Epoch {epoch}: Loss={y.item()}")

六、总结

LoRA 通过对 Transformer 注意力层权重增量进行低秩分解,有效减少训练参数量和计算资源消耗。其采用冻结大模型参数,仅训练低秩矩阵,降低存储和计算开销。并且LORA支持大语言模型和视觉 Transformer 的高效微调,可以兼顾多任务和快速推理。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)