LiveCodeBench:对大语言模型进行全面且无污染的代码能力评估

LiveCodeBench是一个针对大型代码语言模型的评估平台,通过持续收集LeetCode、AtCoder和CodeForces的新题目进行动态更新。其特色包括:1)采用时间戳标记问题,有效防止数据污染;2)提供代码生成、错误修复、代码执行和测试输出预测等全面的评估维度;3)每个场景都设有专门的评估流程。该平台通过跟踪竞赛网站的实时问题更新,为模型评估提供了可靠且无污染的测试环境,并已在官网公开

一、前言

LiveCodeBench: Holistic and Contamination Free Evaluation of

Large Language Models for Code

对大型代码语言模型进行全面且无污染的评估

- paper: https://arxiv.org/pdf/2403.07974

- page:https://livecodebench.github.io/index.html

- leaderboard:https://livecodebench.github.io/leaderboard.html

二、LiveCodeBench

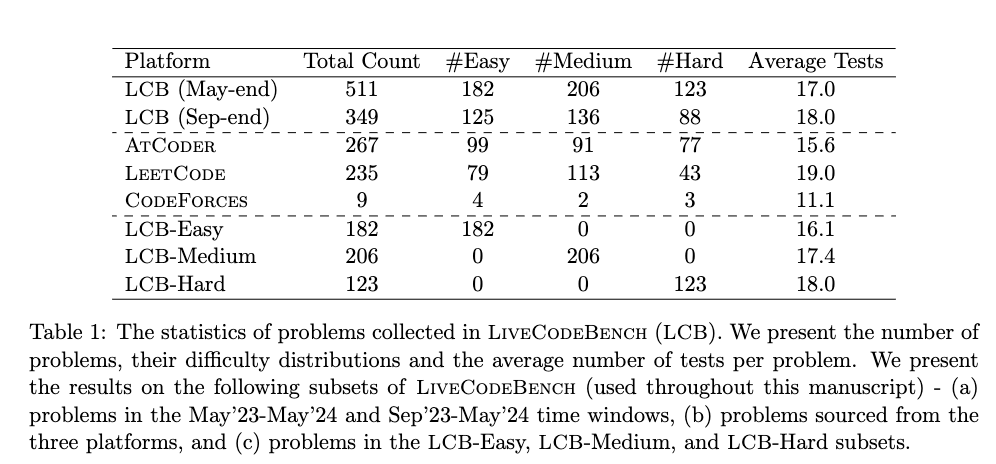

一个全面且无污染的代码 LLM 评估平台,它会随着时间的推移从三个竞赛平台(即 LeetCode、AtCoder 和 CodeForces)的比赛中收集新问题。

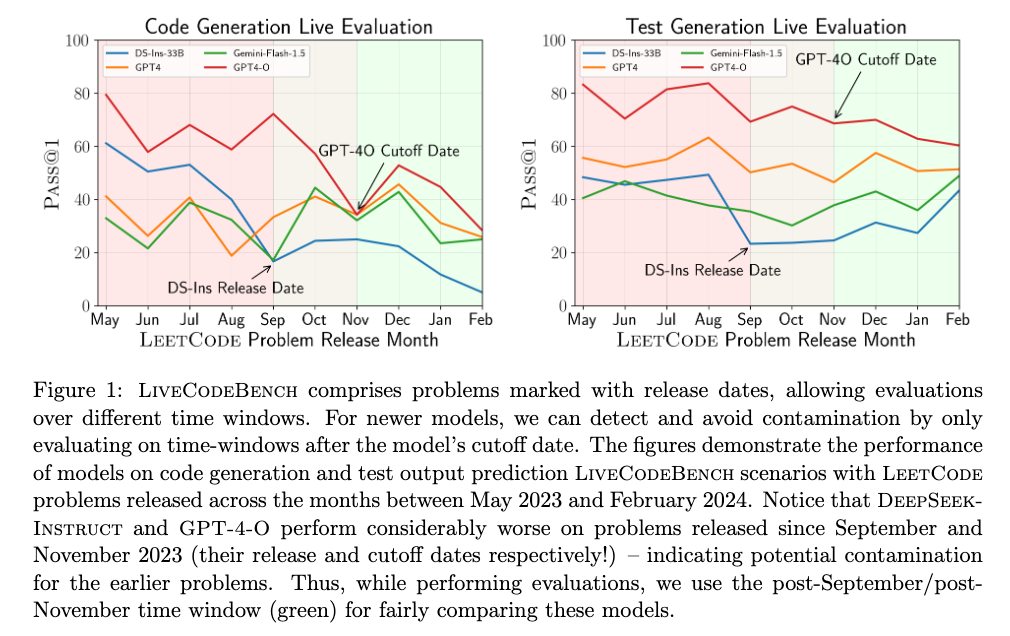

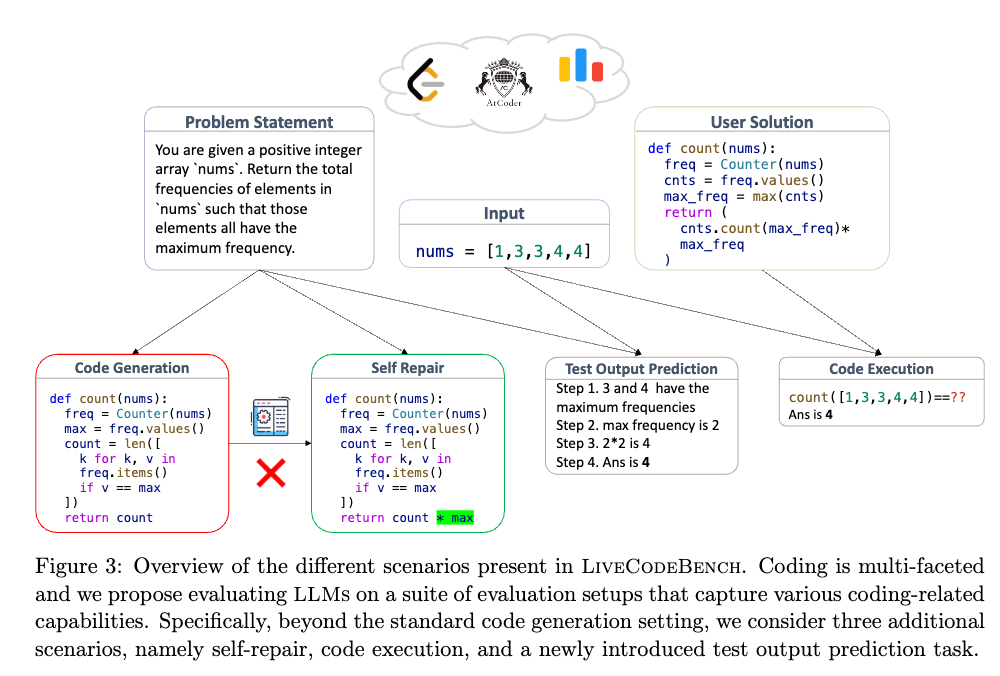

并且这个基准测试还关注更广泛的代码相关功能,例如自我修复、代码执行和测试输出预测,而不仅仅是代码生成。

2.1 实时更新以防止污染

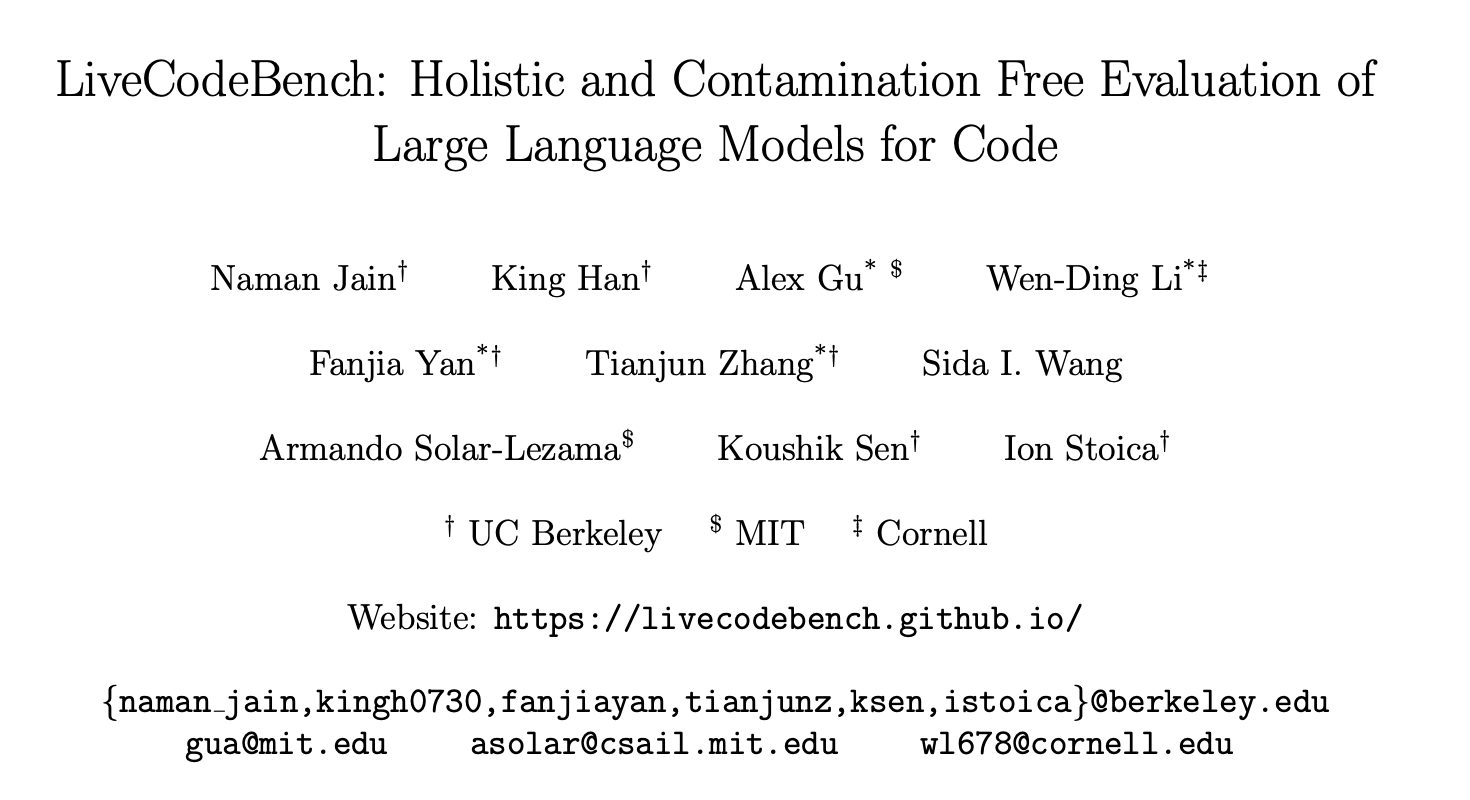

LiveCodeBench 包含标有发布日期的问题,允许在不同时间窗口内进行评估。可以通过仅在模型截止日期之后的时间窗口进行评估来检测并避免污染。

2.2 整体评估

代码生成 + bug fix + 代码执行 + 测试输出预测

每个场景有一套评估流程:

2.3 数据收集

主要是从 LeetCode、AtCoder 和 CodeForces收集以上四种类型代码题目,并打标时间范围。

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)