关于如何搭建anythingllm+ollama(deepseekr1、嵌入模型)+milvus的本地知识库语言模型

关于如何搭建anythingllm+ollama(deepseekr1、嵌入模型)+milvus的本地知识库语言模型

这里只是对于自己在部署过程中踩到的坑做个记录。

以anythingllm为平台,接入基于ollama运行deepseekr1通用模型、嵌入模型,使用milvus作为向量数据库。其中milvus和anythingllm均在docker desktop中运行。

# 一、ollama

1.首先在ollama官网下载并安装ollama。

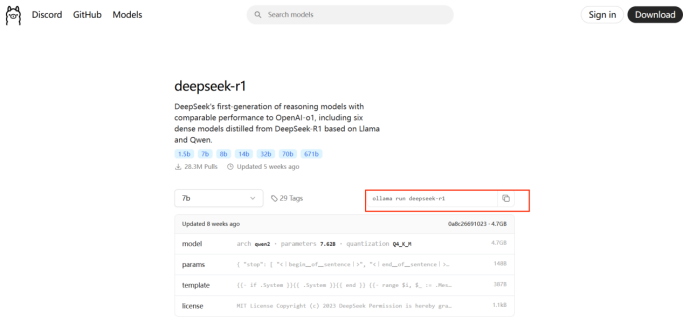

2.然后在官网的model页面中,寻找需要下载的model,我这里需要下载一个通用的deepseekr1模型(大小根据自己配置选择,我的3060选择的是7b的模型)和一个嵌入模型。

在命令框中输入这里的指令就可以下载,可能需要kx上网。

ollama的默认地址:localhost:11434

这里通用聊天模型和嵌入模型就准备完毕了。

# 二、anythingllm

首先需要安装docker,我用的是windows系统,所以安装的是docker desktop,这个去官网安装即可。

在docker desktop中配置好镜像源之后,可以直接搜索到Anythingllm,,下载后在cmd命令行中:

1.设置存储目录set STORAGE_LOCATION=%USERPROFILE%\Documents\anythingllm

2.创建存储目录if not exist "%STORAGE_LOCATION%" mkdir "%STORAGE_LOCATION%"

3.创建 .env 文件 if not exist "%STORAGE_LOCATION%.env" echo. > "%STORAGE_LOCATION%.env"

关键配置项,在 .env 文件中,常见的配置项包括:

SERVER_PORT:指定服务器运行的端口。

JWT_SECRET:用于生成和验证 JWT(JSON Web Token)的密钥。

STORAGE_DIR:指定存储数据的路径。

LLM_PROVIDER:配置大语言模型提供者。

OLLAMA_BASE_PATH:配置 Ollama 服务的基础 URL 地址。

OPEN_AI_KEY:用于访问 OpenAI API 的密钥。

.env 文件中配置的内容会根据你的需求和使用的服务不同而有所变化。

4.在 CMD 中,你可以使用单行命令在Docker运行Anythingllm

docker run -d --name anythingllm --add-host=host.docker.internal:host-gateway --env STORAGE_DIR=/app/server/storage --health-cmd "/bin/bash /usr/local/bin/docker-healthcheck.sh || exit 1" --health-interval 60s --health-start-period 60s --health-timeout 10s -p 3001:3001/tcp --restart=always --user anythingllm -v %STORAGE_LOCATION%:/app/server/storage -v %STORAGE_LOCATION%.env:/app/server/.env -w /app mintplexlabs/anythingllm

这条 Docker 命令启动了一个 AnythingLLM 容器,并通过挂载宿主机的存储目录和 .env 文件,使得容器能够持续存储数据并加载配置。容器以后台运行,并提供 Web 服务,可以通过 http://localhost:3001 (localhost=本机IPv4地址)访问应用。

到这里anythingllm就跑起来了。然后再准备最后的向量数据库(这里使用Milvus)。

# 三、Milvus

参考https://blog.csdn.net/m0_54345753/article/details/136738293这个链接,在docker中安装milvus并运行。

用到的命令

C:\Users\用户名\milvus>docker compose ps 安装和启动

docker compose ps 查询信息

docker port milvus-standalone 19530/tcp 更改端口

minio的地址是http://127.0.0.1:9001(minio)或者localhost:9001(minio) minio的初始账号和密码都是minioadmin

milvus的地址是http://127.0.0.1:19530(milvus)或者http://localhost:19530

# 四、模型设置

这里就全部安装完成了,接下来打开浏览器输入anythingllm的地址http://localhost:3001。

之后在设置中设置通用模型,接下来一定要先设定嵌入模型,再设定向量数据库模型才不会报错。

这里有一个坑,如果在对话中报了

An error occurred while streaming response. network error或者

14 UNAVAILABLE: No connection established. Last error: connect ECONNREFUSED 127.0.0.1:19530 (2025-03-20T03:12:18.601Z)

两种错误,则是因为AnythingLLM在Docker容器中运行,需将嵌入模型和向量数据库的地址都改为宿主机的IP(如192.168.x.x)或Docker网络别名(如host.docker.internal)。

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来: 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献207条内容

已为社区贡献207条内容

所有评论(0)