本地部署DeepSeek大模型的基本方法

本文介绍了在Windows系统上安装和使用Ollama框架及DeepSeek模型的步骤。主要包括:1)安装Ollama程序并自动下载DeepSeek模型;2)通过设置环境变量开放外部访问权限(OLLAMA_HOST和OLLAMA_ORIGINS);3)在Edge浏览器安装PageAssist插件连接服务;4)远程访问时需填写服务器IP地址(如http://10.100.183.50:11434/)

在Windows中按照下载对应的框架:点击这里Ollama

正常安装Ollama程序

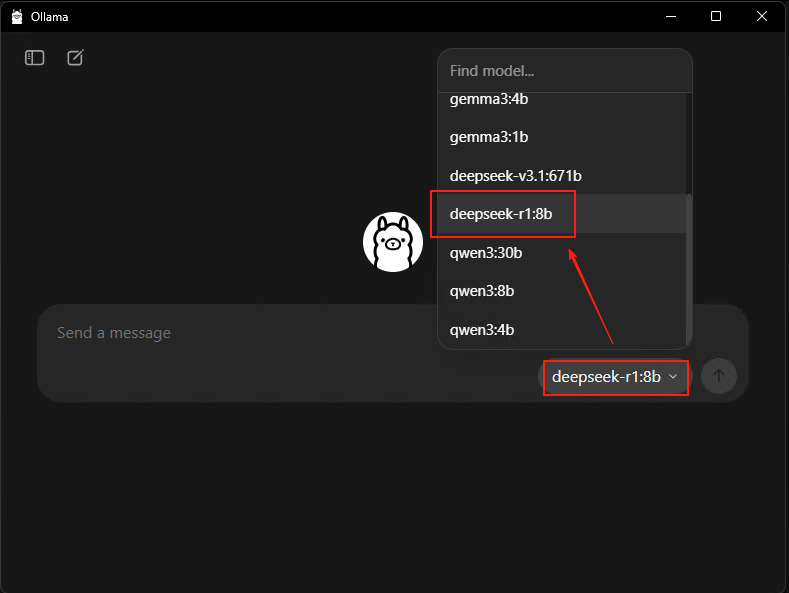

然后点击下图中的内容,然后随便在文本框里面输入一句话,则程序会自动下载DeepSeek的模型

下载完成后,输入如下指令让外部的设备也能访问改机器,记得要重启哦

##在Window环境中输入如下两个指令就可以直接ollama访问方式对外了

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

setx OLLAMA_KEEP_ALIVE -1客户端访问方法

在微软的edge浏览器的地址栏中输入如下的插件下载地址

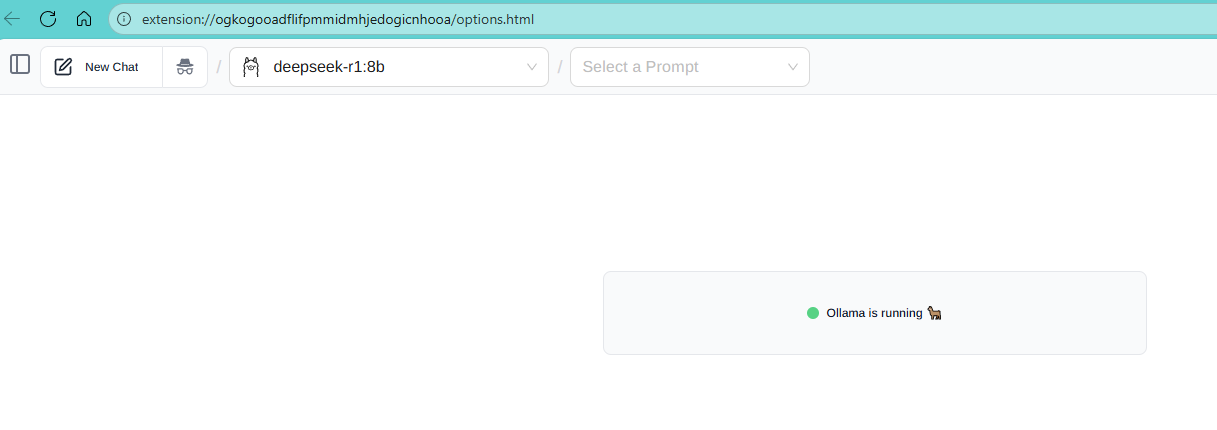

Page Assist - A Web UI for Local AI Models - Microsoft Edge AddonsMake Microsoft Edge your own with extensions that help you personalize the browser and be more productive.![]() https://microsoftedge.microsoft.com/addons/detail/page-assist-a-web-ui-fo/ogkogooadflifpmmidmhjedogicnhooa?hl=zh-CN安装完成后,就可以在打开的插件中使用了,记得要换对应架设服务器的对应的IP地址,如果是本地的访问,就可以直接用该插件自己带的地址就可以了

https://microsoftedge.microsoft.com/addons/detail/page-assist-a-web-ui-fo/ogkogooadflifpmmidmhjedogicnhooa?hl=zh-CN安装完成后,就可以在打开的插件中使用了,记得要换对应架设服务器的对应的IP地址,如果是本地的访问,就可以直接用该插件自己带的地址就可以了

例如我架设的远程服务器地址:http://10.100.183.50:11434/

上面的表示ollama的服务已经在运行了,左上角选择对应的deepseek的模型就可以了;

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)