Gemini API 批量处理(Batch Size)和代币(Token)效率

本文探讨了Gemini API的两大优化策略:批量处理(Batch Size)和代币(Token)效率。批量处理API适合非实时高吞吐量场景,能节省50%成本但不会降低延迟。系统指令(System Prompt)结合上下文缓存(Context Caching)可显著节省代币消耗,缓存重复内容可享受高达90%折扣。优化策略包括:Batch API用于批量处理降低成本,Context Caching减

Gemini API 批量处理(Batch Size)和代币(Token)效率

目录

您提出的问题涉及到了 Gemini API 使用中的两个关键优化策略:批量处理(Batch Size)和代币(Token)效率。

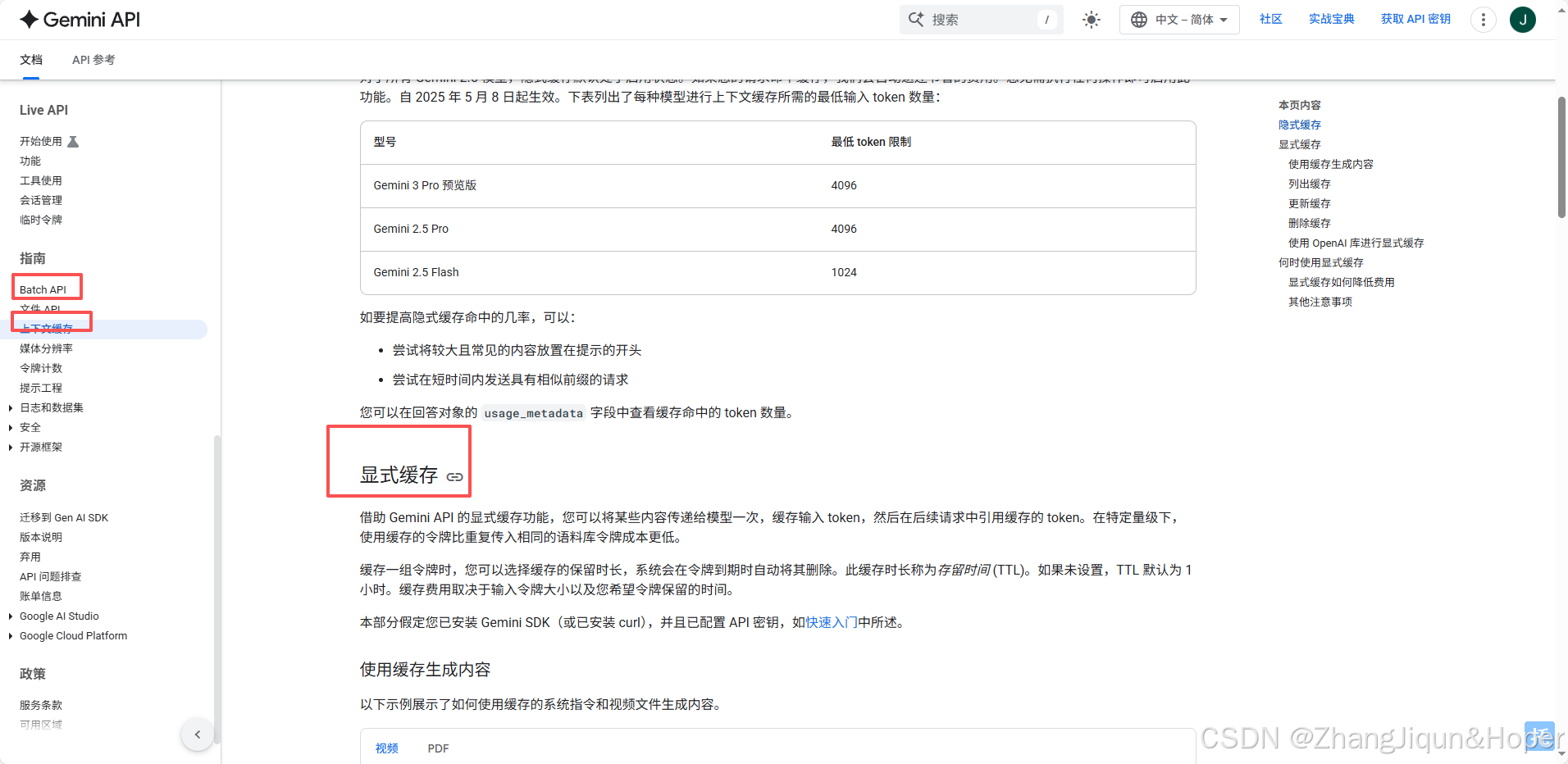

使用batch API

显示缓存

1. 批量处理(Batch Size)的使用和效果

结论: 可以使用批量处理(Batch),但它是针对非实时、高吞吐量的场景设计的。

✅ 使用 Batch API 的益处

Gemini API 提供了 Batch API(models.batchGenerateContent),主要用于处理大量相互独立的请求,其核心优势在于:

| 方面 | 详细说明 | 优势/目的 |

|---|---|---|

| 异步处理 | 提交请求后立即返回,结果在稍后异步返回(目标周转时间在 24 小时内)。 | 适用于非实时任务,无需等待每个请求完成。 |

| 成本节省 | 批量请求的价格比标准实时 API 便宜 50%。 | 大规模数据预处理、评估或内容批量生成时,能显著节省成本。 |

| 高吞吐量 | 具有更高的速率限制(Rate Limits)。 | 适合需要一次性处理数十万甚至数百万请求的场景。 |

| 提交方式 | 可以通过 Inline requests(适合小批量,<20MB)或上传 JSONL 文件(适合大批量,最大 2GB)。 | 方便灵活地提交不同规模的任务。 |

❌ 对速度(Latency)的影响

- Batch API 并不能加快单次请求的速度(延迟/Latency)。 相反,由于它是异步处理,不保证实时响应,因此不适合需要即时反馈的应用(如聊天机器人)。

总结: 如果您的任务是批量、非紧急的数据处理(例如,批量翻译、摘要生成),Batch API 是最佳选择,可以大幅节省成本。

2. 使用 System Prompt 节省 Token 和加快速度

结论: 使用 System Prompt(或称为 System Instruction)可以帮助节省代币(Token),但其主要作用是提高模型性能和一致性。

🪙 节省 Token 的原理:上下文缓存(Context Caching)

Gemini API 提供了 **Context Caching(上下文缓存)**功能,这是实现系统指令等重复上下文节省 Token 的关键机制:

-

明确缓存 (Explicit Caching):

- 您可以通过 API 将一段文本(如您的System Prompt/System Instruction,或一个长文档)缓存起来。

- 后续的

GenerateContent请求可以通过引用这个缓存,而无需重复发送完整的文本内容。 - 被缓存的 Token 在后续使用时,计费会享受大幅折扣(例如 90% 的折扣),从而实现成本节省。

- 这种方法特别适合在聊天会话中重复使用相同的系统指令或背景信息。

-

System Prompt 的 Token 消耗:

- System Prompt(系统指令)本身是计入您的输入 Token 总数的。

- 如果没有使用 Context Caching,在每次 API 调用中重复发送相同的 System Prompt,会重复消耗 Token。

🚀 加快速度(延迟/Latency)的影响

- 直接作用有限: System Prompt 的主要作用是指导模型行为,它本身不会直接加快模型的推理速度。

- 间接优化: 一个简短、精确的 System Prompt 可以帮助模型更快地理解任务和限制输出格式,从而可能间接加快模型的“思考”时间(特别是对于需要复杂推理的模型,如 Gemini 3 Pro,可以通过设置

thinking_level来优化延迟)。 - Context Caching 加速: 当您通过缓存机制使用 System Prompt 时,由于实际传输和处理的输入 Token 变少,理论上有助于减少延迟。

总结: System Prompt 的主要价值在于提高生成质量和行为一致性,而Context Caching是实现节省 Token 和间接提升速度的关键技术。

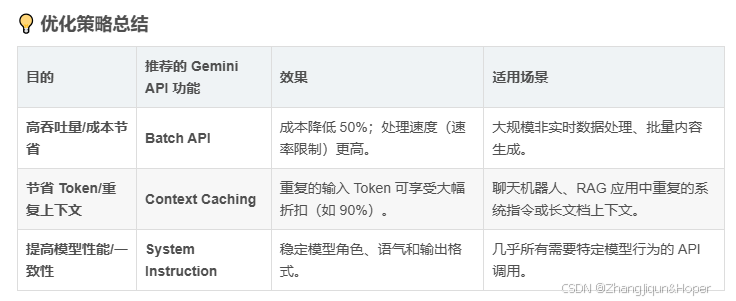

💡 优化策略总结

| 目的 | 推荐的 Gemini API 功能 | 效果 | 适用场景 |

|---|---|---|---|

| 高吞吐量/成本节省 | Batch API | 成本降低 50%;处理速度(速率限制)更高。 | 大规模非实时数据处理、批量内容生成。 |

| 节省 Token/重复上下文 | Context Caching | 重复的输入 Token 可享受大幅折扣(如 90%)。 | 聊天机器人、RAG 应用中重复的系统指令或长文档上下文。 |

| 提高模型性能/一致性 | System Instruction | 稳定模型角色、语气和输出格式。 | 几乎所有需要特定模型行为的 API 调用。 |

❓ 您希望了解更多哪方面的内容?

您是否想深入了解如何通过代码实现 Context Caching,以便在多次 API 调用中复用 System Prompt 或长文档?

火山引擎开发者社区是火山引擎打造的AI技术生态平台,聚焦Agent与大模型开发,提供豆包系列模型(图像/视频/视觉)、智能分析与会话工具,并配套评测集、动手实验室及行业案例库。社区通过技术沙龙、挑战赛等活动促进开发者成长,新用户可领50万Tokens权益,助力构建智能应用。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)